8月23日(火)より3日間開催される、CEDEC2022において開講された「『プロジェクトセカイ カラフルステージ! feat. 初音ミク』 リアルタイム配信型バーチャルライブの開発事例」の様子をレポートする。

本講座は、『プロジェクトセカイ カラフルステージ! feat. 初音ミク』内にて開催された「コネクトライブ」の大きな特徴である「ライブ感」の演出や、その開発、当日の運営などについてアニメーターの藤本誠人氏、サウンドディレクターの磯田泰寛氏、エンジニアの山口智也氏がそれぞれの視点から解説するセッション。以下の6つのトピックから実際の開発事例などに迫った。

文/anymo

ライブのコンセプトデザイン・演出制作

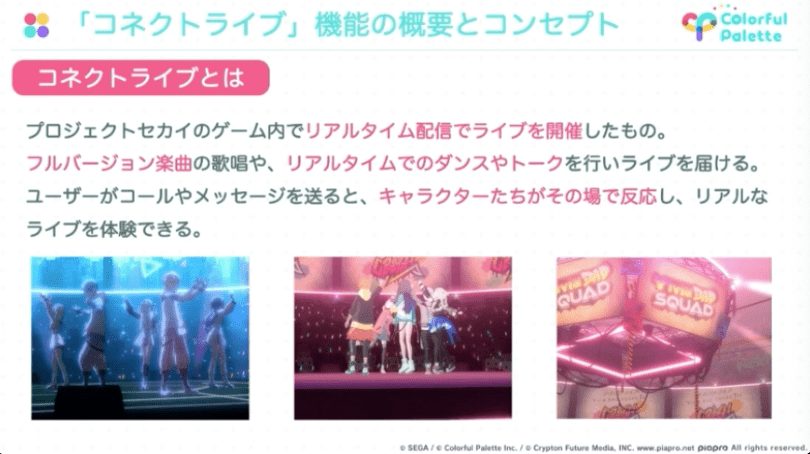

まず、セッションの中心となる「コネクトライブ」についての解説がされた。本ライブは『プロセカ』内でリアルタイム配信にてライブを開催した試みで、キャラクターたちがゲーム中のMVとは異なるフルバージョン楽曲を披露するほか、ユーザーの反応に対してキャラクターたちが返答するなど、よりリアルなライブ体験が楽しめるものとなっている。

最初に登壇したのは藤本誠人氏。「ライブのコンセプトデザイン・演出制作」についての解説を行った。

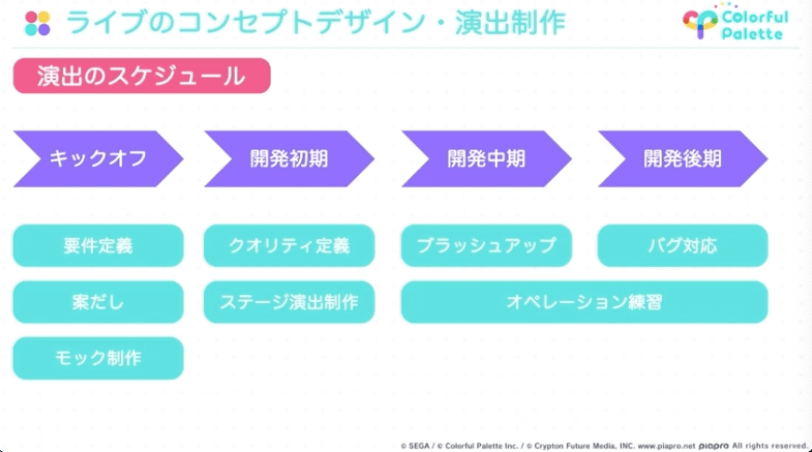

ライブ演出はアセットとして制作されており、制作環境はUnity Timeline、制作人数はColorful Paletteアニメーション演出班の4名。それぞれの段階でどのようにライブ演出が完成されていったのかを、演出のスケジュールに沿って追う。

「キックオフ」では、どのような機能なのか、どのようなアセットが必要なのか、最終的に目指すゴールといった要件を確認。その後、定義された「コネクトライブ」の要件に向けて開発がスタート、プロトタイプの制作が開始する。

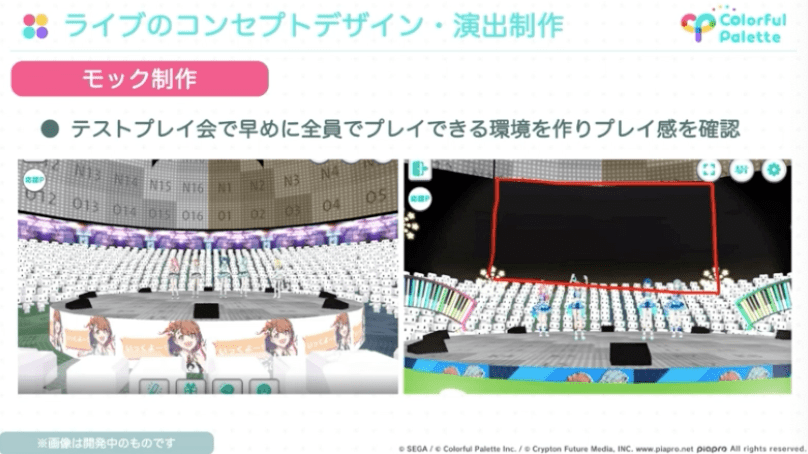

プロトタイプは早めに制作し、全員でプレイ感を確認。テストプレイ会を踏まえ、静止画上に直接レタッチして演出の見た目を模索することで、どのアセットが必要なのかを洗い出す。スライドでは、実際に静止画上にレタッチした画像も公開された。

CEDEC2022「『プロジェクトセカイ カラフルステージ! feat. 初音ミク』 リアルタイム配信型バーチャルライブの開発事例」より

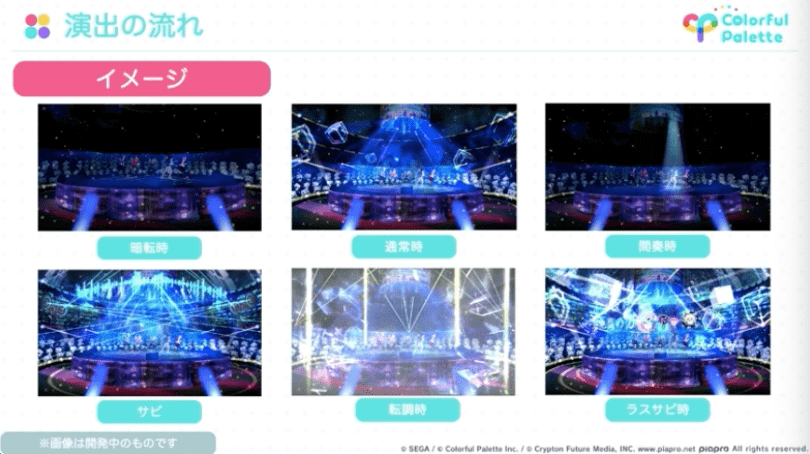

実際にライブ演出の実現に必要なトラックとして会場全体の空気感を作るポストエフェクト、ライティング、エフェクトやモニター映像などのアセット類などといったものが挙げられ、それらを基に楽曲演出を確認できる演出をベンチマークとして制作。

その後、その定められたクオリティラインに沿って他の楽曲の演出を制作、全体の流れを確認する、というルートで「コネクトライブ」にて披露される7曲の演出が制作された。

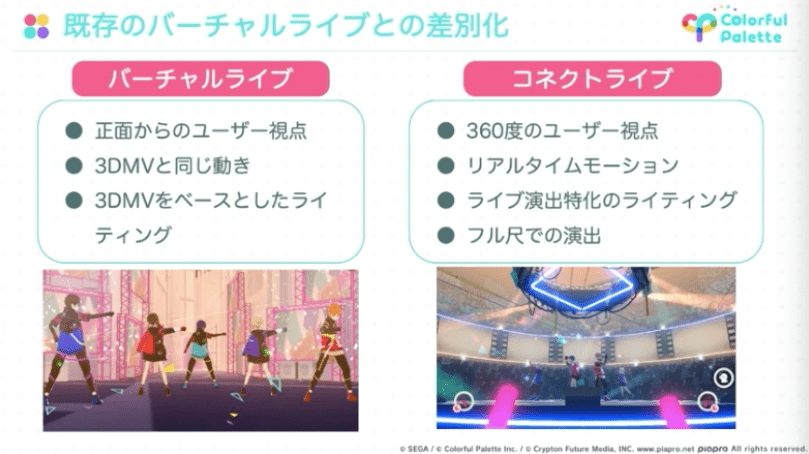

また、演出のポイントとしてユーザーが自由に移動できるステージということから、最前列・中段列・カメラズームのどの視点から見てもライブの邪魔にならないライティング、フレアやフォグによる会場全体の雰囲気作り、ゲーム内の「バーチャルライブ」との差別化といったものが挙げられた。

全体のアセットが揃い、本番想定の環境でのテクニカルリハーサルを実施。演出をふくむライブ全体のクオリティや、アセット・機能の不足点の確認を経て、ブラッシュアップをしていった。

テクニカルリハーサル後にはリアルタイム感をより楽しめるようユーザーの声が表示される「コール&レスポンス」機能を実装した。

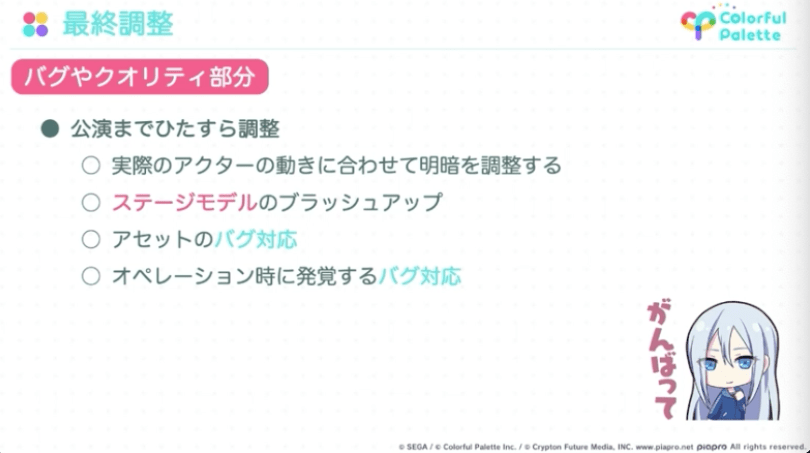

その後、演出チームでは公演までの期間にバグの対応やクオリティアップのための調整を繰り返していたほか、当日はステージ照明の操作やキャラクターの衣装変更などといったオペレーションを担当していたとのことだ。

また、アクターの動きに合わせる演出作りや、描画負荷の軽減など難しかった点についても言及した。

配信スタジオでのオペレーション

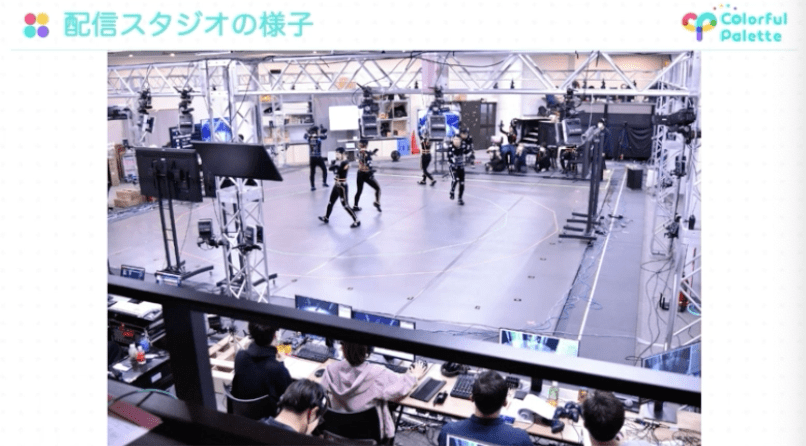

次に登壇したのは、サウンドディレクターの磯田泰寛氏。モーション、表情操作、ステージ演出、音響、キャラクターボイスと台本の管理、配信システムの管理、進行などといった50名ほどで構成されるチームによる配信当日のスタジオでのオペレーションについて、各チームの実際の稼働の様子の写真を交えながらの解説となった。

モーションアクターによる動きをリアルタイムにキャプチャ・配信する今回のライブでは、360度の円形ステージを用意、四方のモニターに配信映像・台本を表示したほか、アクターはイヤモニを装着の上で指示を聴きながら動きをつけていったとのこと。

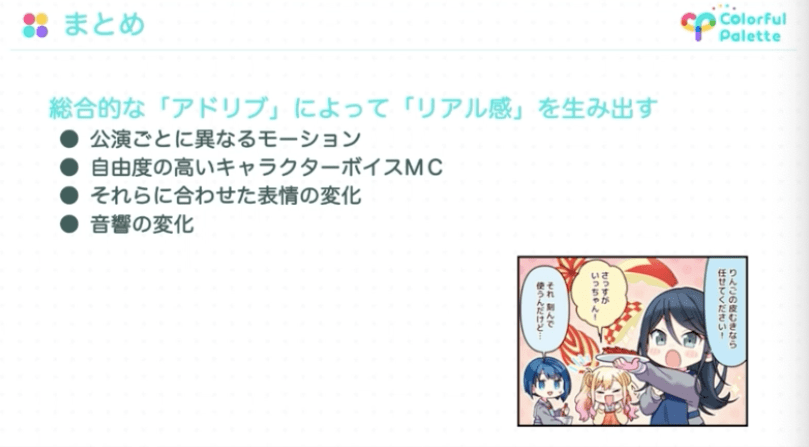

「ライブ感」の演出として声優には「アドリブをたくさん行ってください」という指示を出し、実際にモーションアクターがそのアドリブにあわせて臨機応変に対応した。

セッションでは、1日3回の公演でのMCの内容を反映させ、それぞれ異なる動きを見せる実際の動画を放映。キャラクターが直前のMCの内容に沿った振り付けを披露している姿が確認できた。

また、キャラクターの表情は、コントローラーを用いてまばたきに至るまで手動で制御していた。

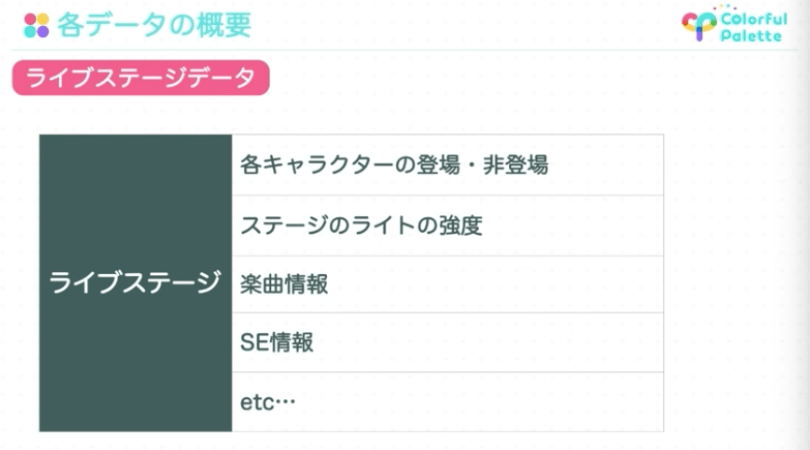

ステージ演出の制御も、ほかのチームと同じくリアルタイムで進行。事前にアセットとして制作されたライブ演出をスタートさせるほか、キャラクターの表示非表示や明転・暗転、BGMやガヤなど状況に応じて変化するものはリアルタイムでの制御を採用している。なお、ステージ演出の自動再生と手動で制御する部分の組み合わせはリアルなライブと似たものとなっているとのことだ。

音響演出では効果音など、特にMC中のガヤなどをコントローラーにてリアルタイムで制御することで「ライブ感」を演出している。

ライブ配信システムの全体構成

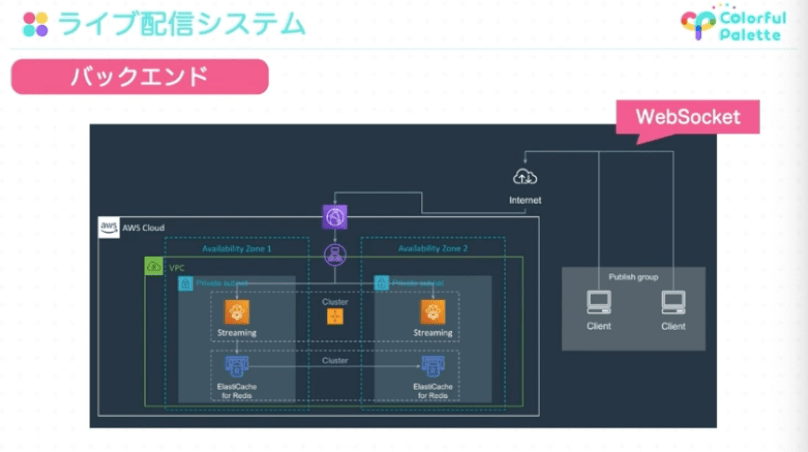

最後に登壇したのはエンジニアの山口智也氏。ライブ配信システムの開発・実装をふくむ全体構成について解説した。

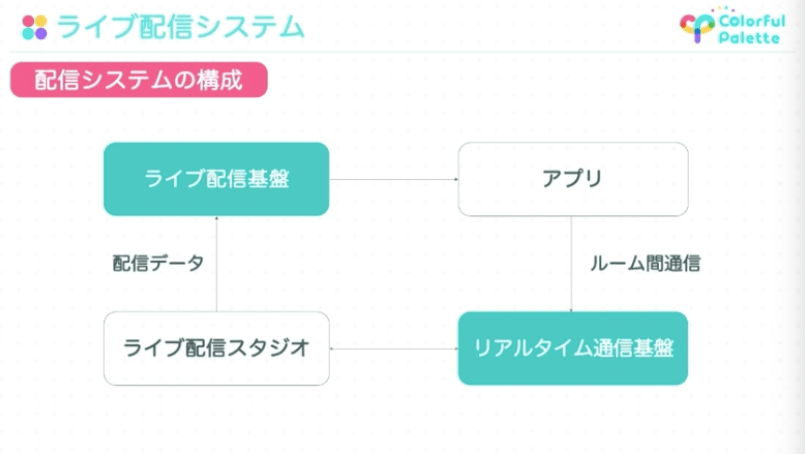

ライブ配信システムは「コネクトライブ」専用のライブ配信・視聴システムを構築したとのこと。配信システムの構成は以下のとおり。

CEDEC2022「『プロジェクトセカイ カラフルステージ! feat. 初音ミク』 リアルタイム配信型バーチャルライブの開発事例」より

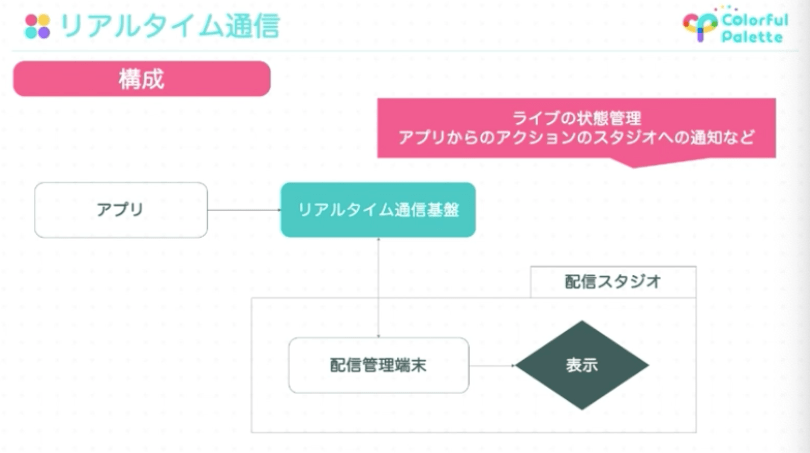

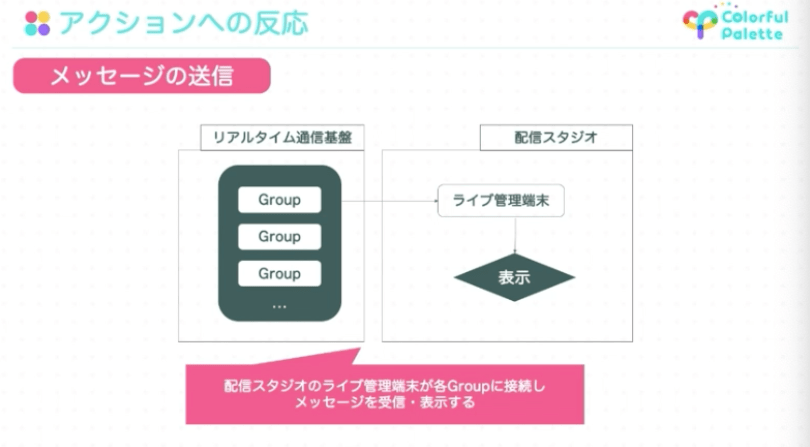

ライブ配信スタジオにて収録された配信データは、ライブ配信基盤を通してユーザーのもとへと届き、ユーザーからのアクションはリアルタイム通信基盤を通じてライブ配信スタジオへと届けられる。

ユーザーの端末はリアルタイム通信基盤に接続しており、アクションをライブ配信スタジオに届けるほかにもライブの開場・閉場といったライブの状態管理もリアルタイム通信基盤を通して行われる。

|

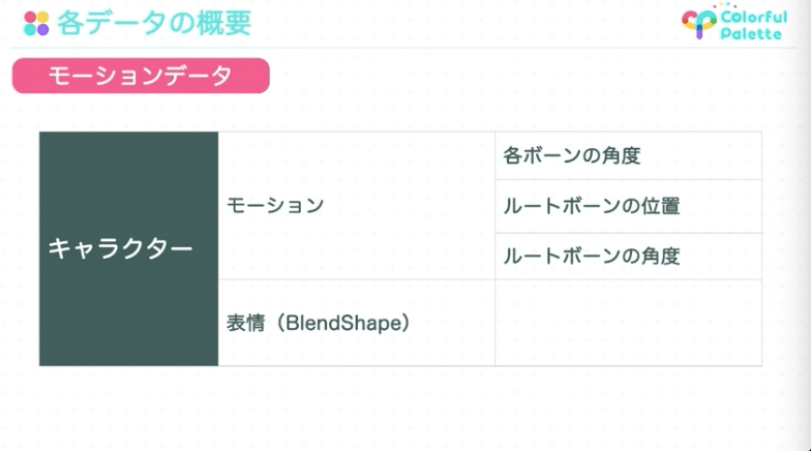

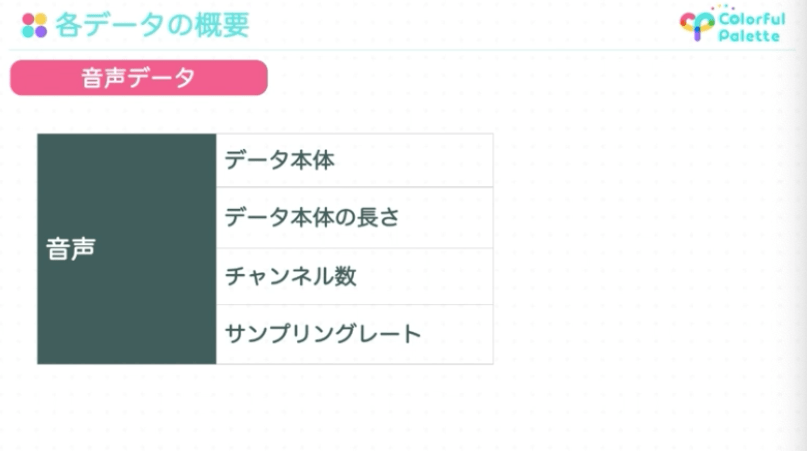

コネクトライブで送受信しているデータは、モーションデータ(モーション、表情)・音声データ・ライブステージデータの3つ。独自のフォーマットでシリアライズ・gzip圧縮することでデータサイズを削減しているほか、音声データはCRIの高圧縮・高音質な音声コーデックである「HCA」でエンコードしているとのことだ。

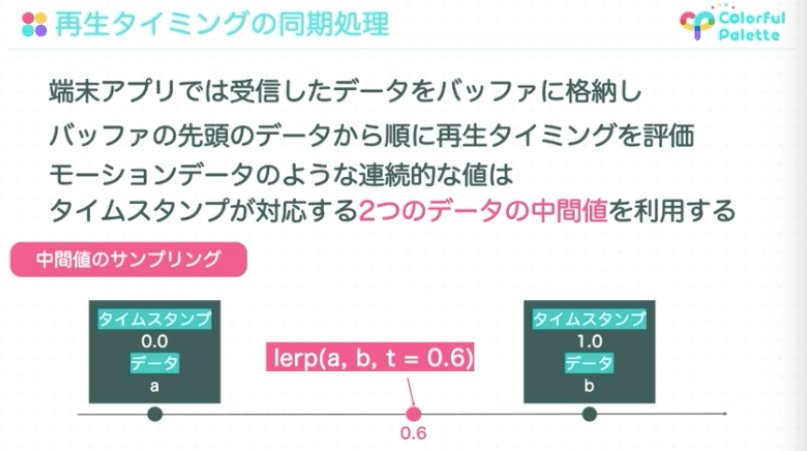

また、配信したデータにタイムスタンプを付与、モーションデータなどの連続的な値はタイムスタンプに対応するふたつのデータの中間値を利用するなど、ユーザーの再生速度に差が出ないような工夫もされている。

コネクトライブの強みであるライブ感のある体験を支える、ユーザーからのアクションにキャラクターが反応することや、「ペンライトトーク」機能といった試みについても解説。

ユーザーはそれぞれリアルタイム通信基盤の“Room”および、Roomを束ねる“Group”に割り振られ、Room内の代表ユーザーのアクションがGroupに送信されることでユーザーのアクションを各Groupに集約、ユーザーの反応を収集することが可能となる。

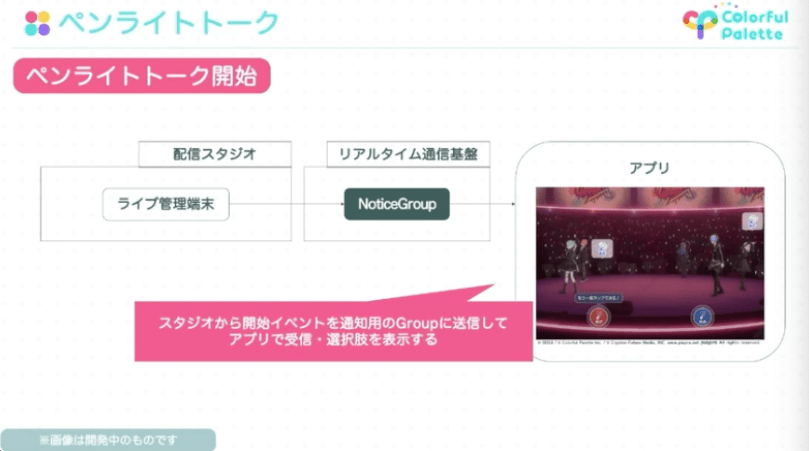

「ペンライトトーク」は、ライブ中にペンライトのカラーを変えて投票などのコミュニケーションが楽しめる機能。先述の”Room”とは異なり、ライブ配信端末からユーザー全員が個別に接続している“NoticeGroup”を通じてユーザーの端末にペンライトトークの開始イベントが発行される。

さらに、ペンライトトーク中にユーザーがペンライトの色を変えると、Room、Groupを通じて情報を収集、ライブ管理端末に届けられ、実際にアプリ内のライブ会場にその結果が反映されるといった仕様になっている。

まとめ

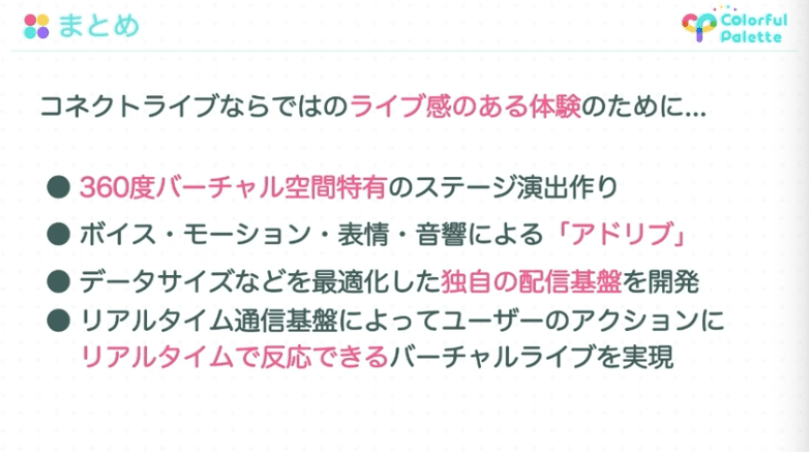

コネクトライブではアドリブや独自の配信基盤などによって「ライブ感」のある体験を作り上げており、セッションの最後に山口氏は「今後もユーザーの皆様に多くの感動と驚きを与えられるよう、鋭意開発を進めていきます」と締めた。

なお、本セッションのスライドは後日に配布予定とのことだ。CEDEC2022は8月25日(木)まで開催中。一部の講演は無料で配信されているので、あわせてチェックしてほしい。