ニューラルレンダリングの時代がやってきた

次にBlackwellアーキテクチャについて紹介が行われた。画質を向上させるということは、計算とストレージに飽くなき欲求を求めていくようなものだ。

先進的なマテリアルやジオメトリーの複雑性についても処理していかなくてはならない。また、先進的なライティングテクニックもある。そのため、シーンはどんどん複雑になっていく。

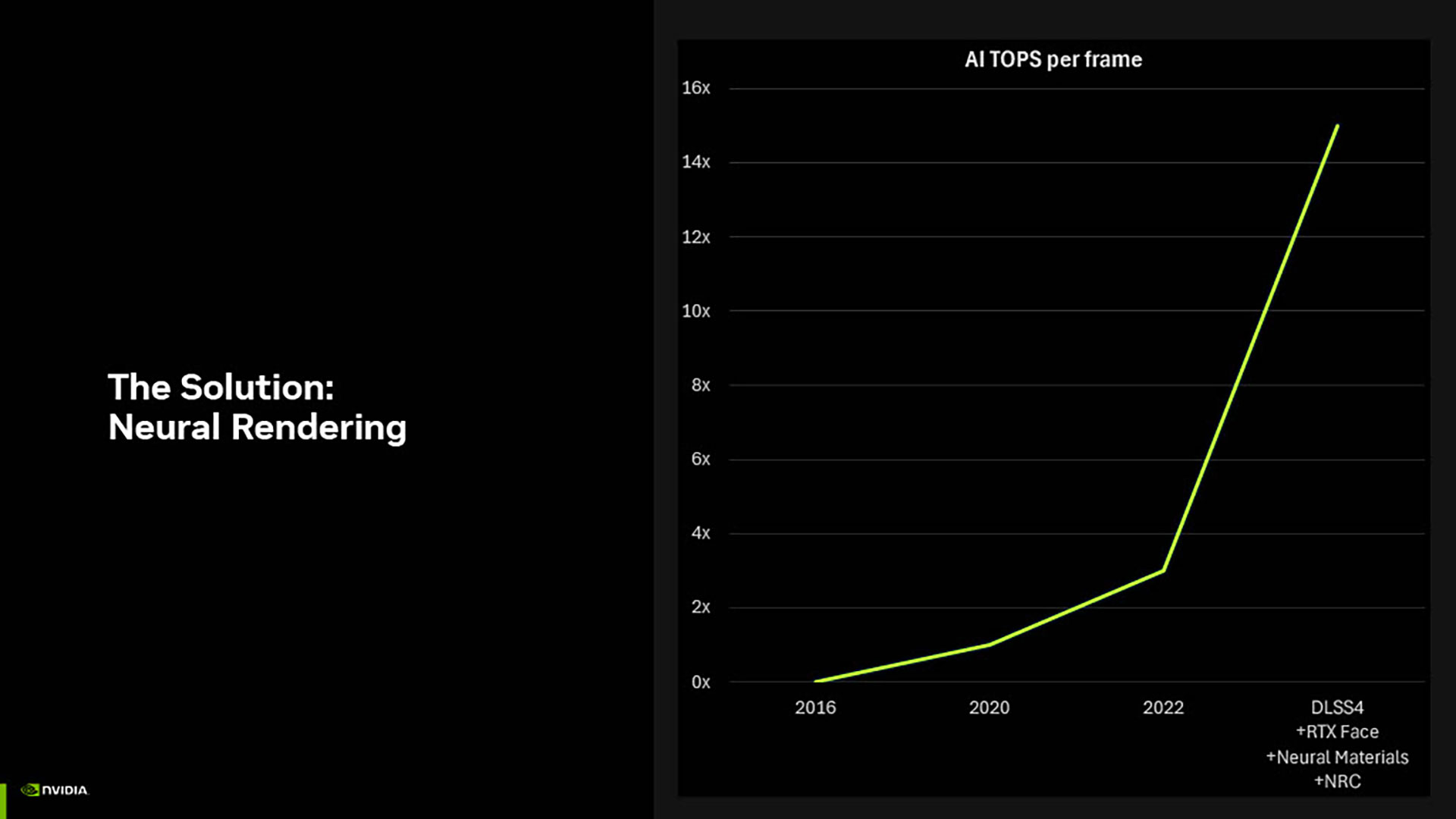

ムーアの法則が終わらないと仮定したとしても、従来のやり方でこうしたものに対処していくのは無理がある。そこでニューラルレンダリングを使うことで、すでにムーアの法則を超えて進化をし続けてきたのである。そして、こうした傾向は今後も続いていくものだ。

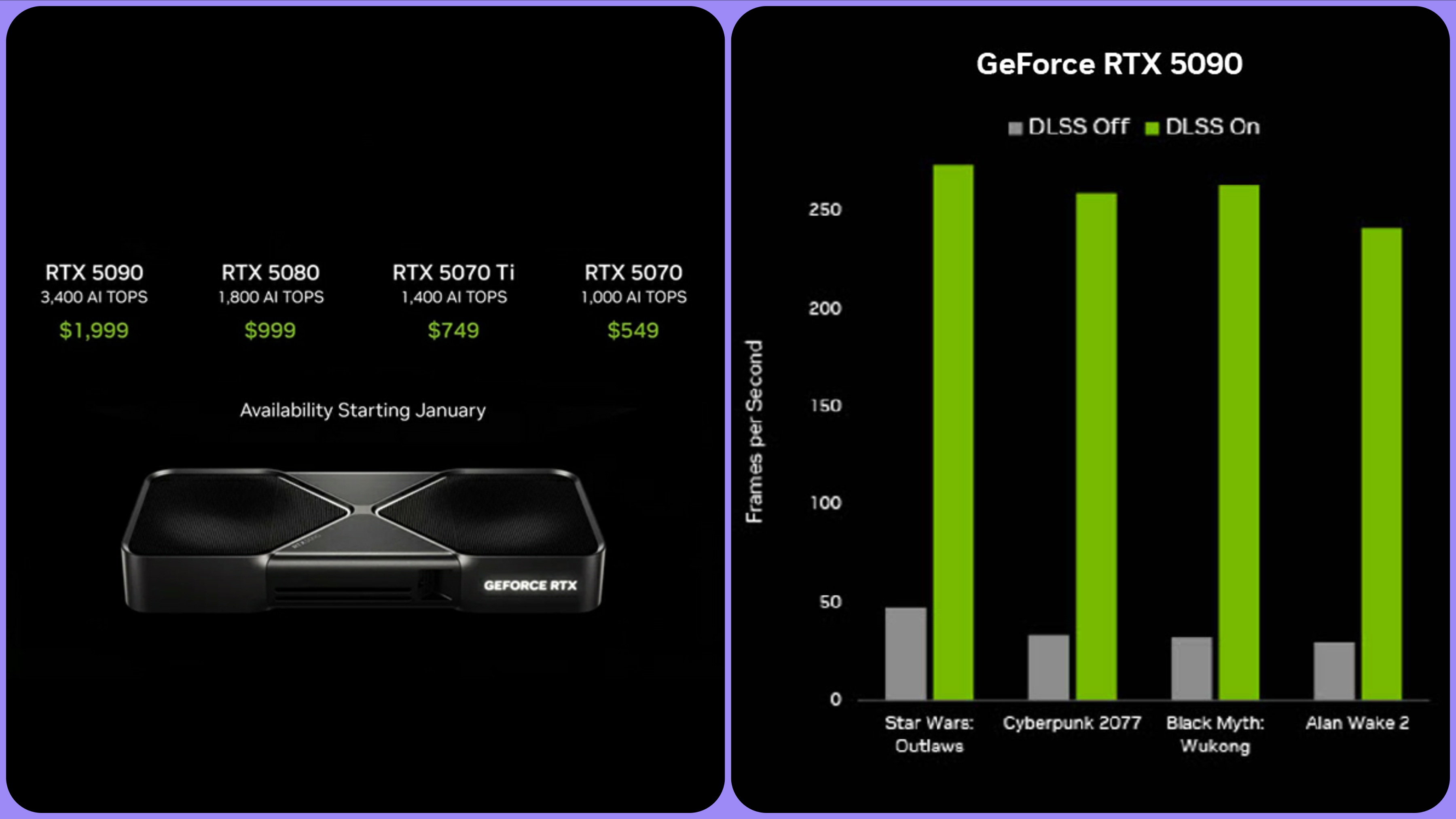

DLSSは、ニューラルレンダリングを使うことで従来まで行われてきたレンダリングの数分の1でフレームレートを劇的に上げていくことができる。DLSS 4では、新しいニューラルレンダリングのテクノロジーが使われているのだ。そのため、まさにニューラルレンダリングの時代がやってきたともいえる。

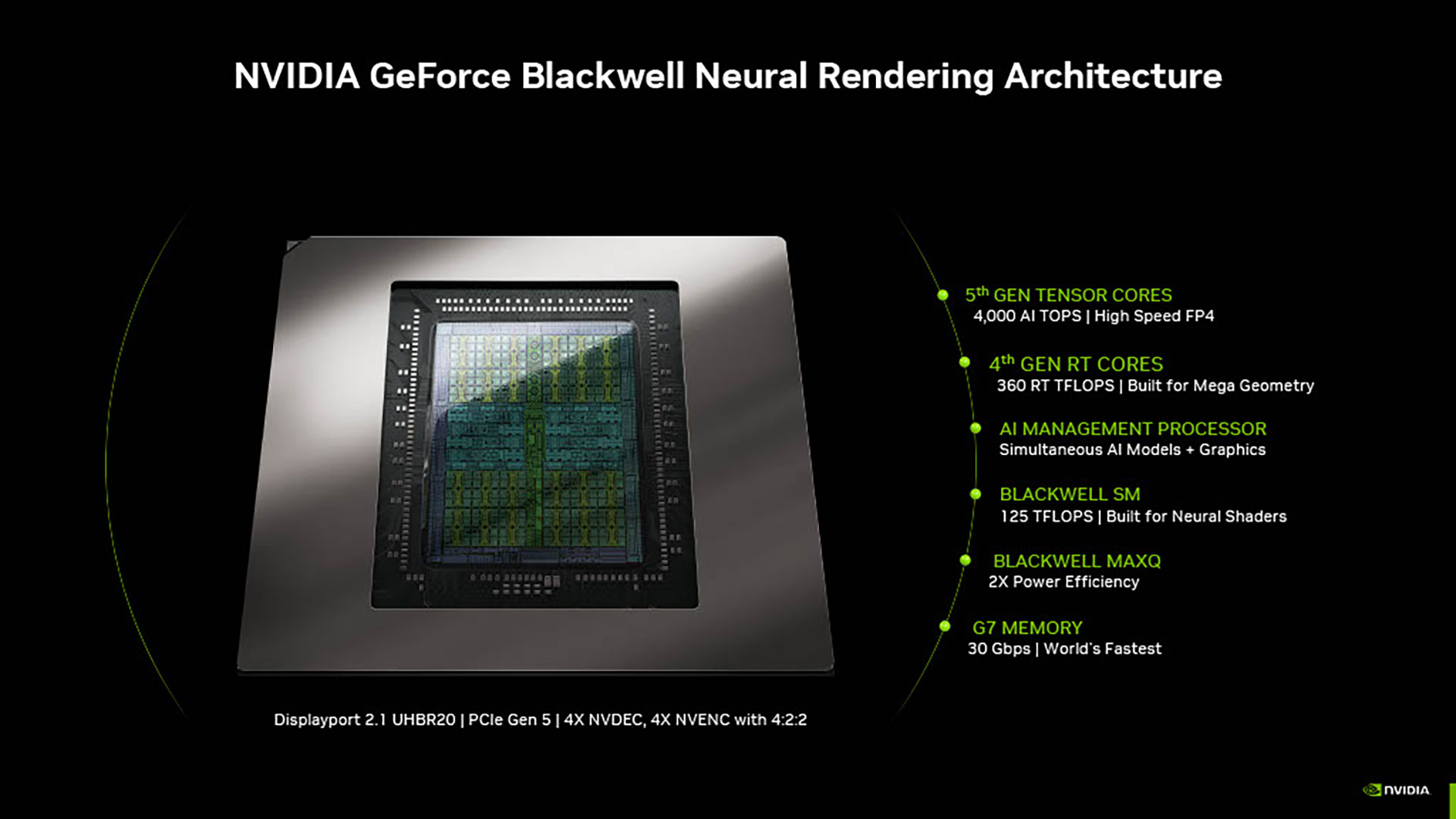

Blackwellは、最初から明確なゴールを決めて設計が行われている。まずは、新しいニューラルワークロードを最適化して、AIのパフォーマンスを向上させる。メモリー使用量を削減し、サービス品質を維持しながら、非同期のAIワークロードを実行できる能力を実現。そしてエネルギー効率を改善していく。

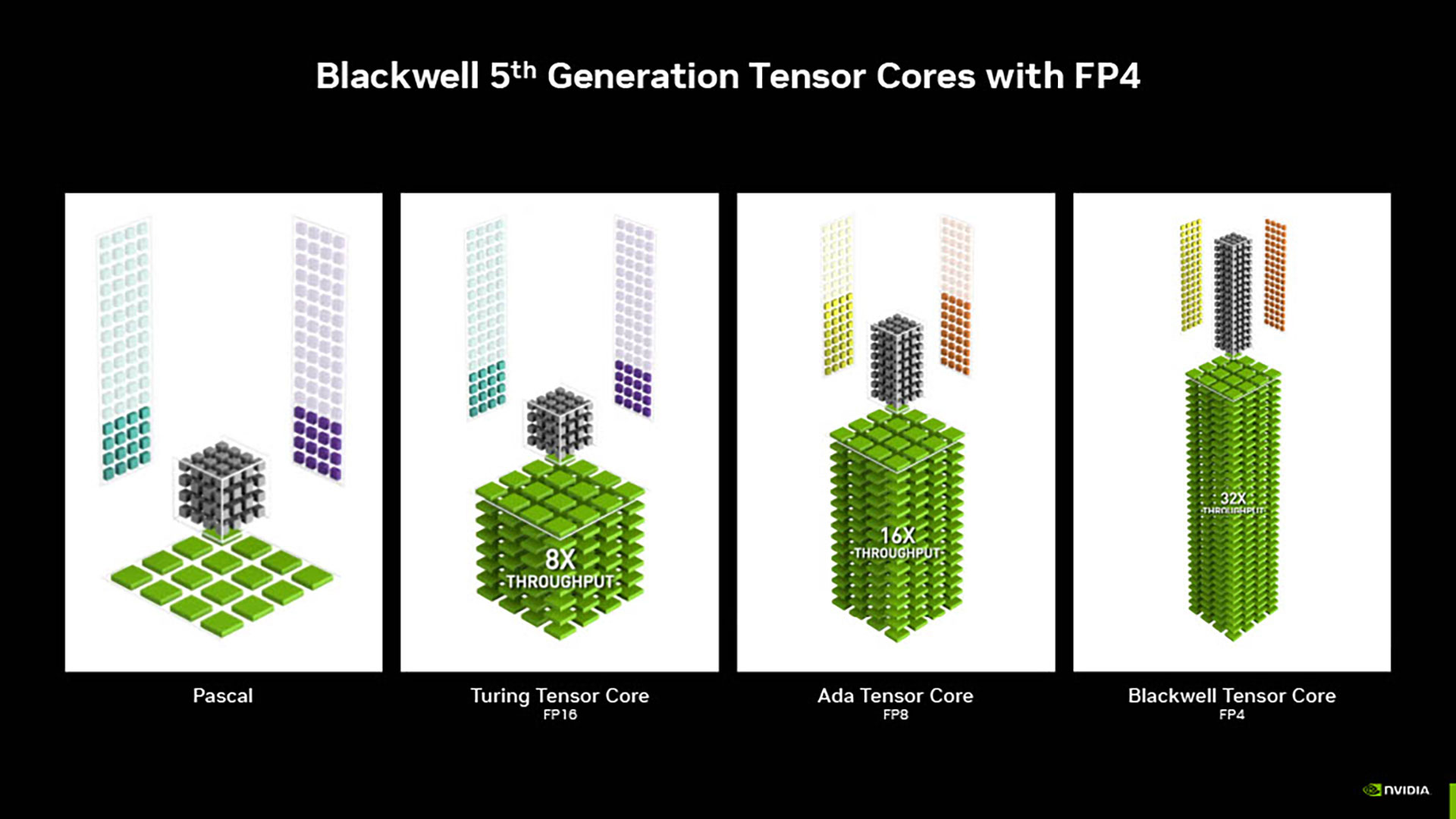

Blackwellでは、第5世代のTensorコアとデータフォーマットのFP4をサポートしている。また、第4世代のレイトレーシングコアにより、「RTX Mega Geometry」もサポート。重要な作業をスケジューリングするために、新しいAIマネージメントプロセッサーも導入されている。

さらに、ニューラルシェーダーを実行できるBLACKWELL SM(ストリーミングマルチプロセッサー)を導入。MAXQテクノロジーにおいても、パフォーマンスの改善と電力効率を上げるための最適化が行われている。

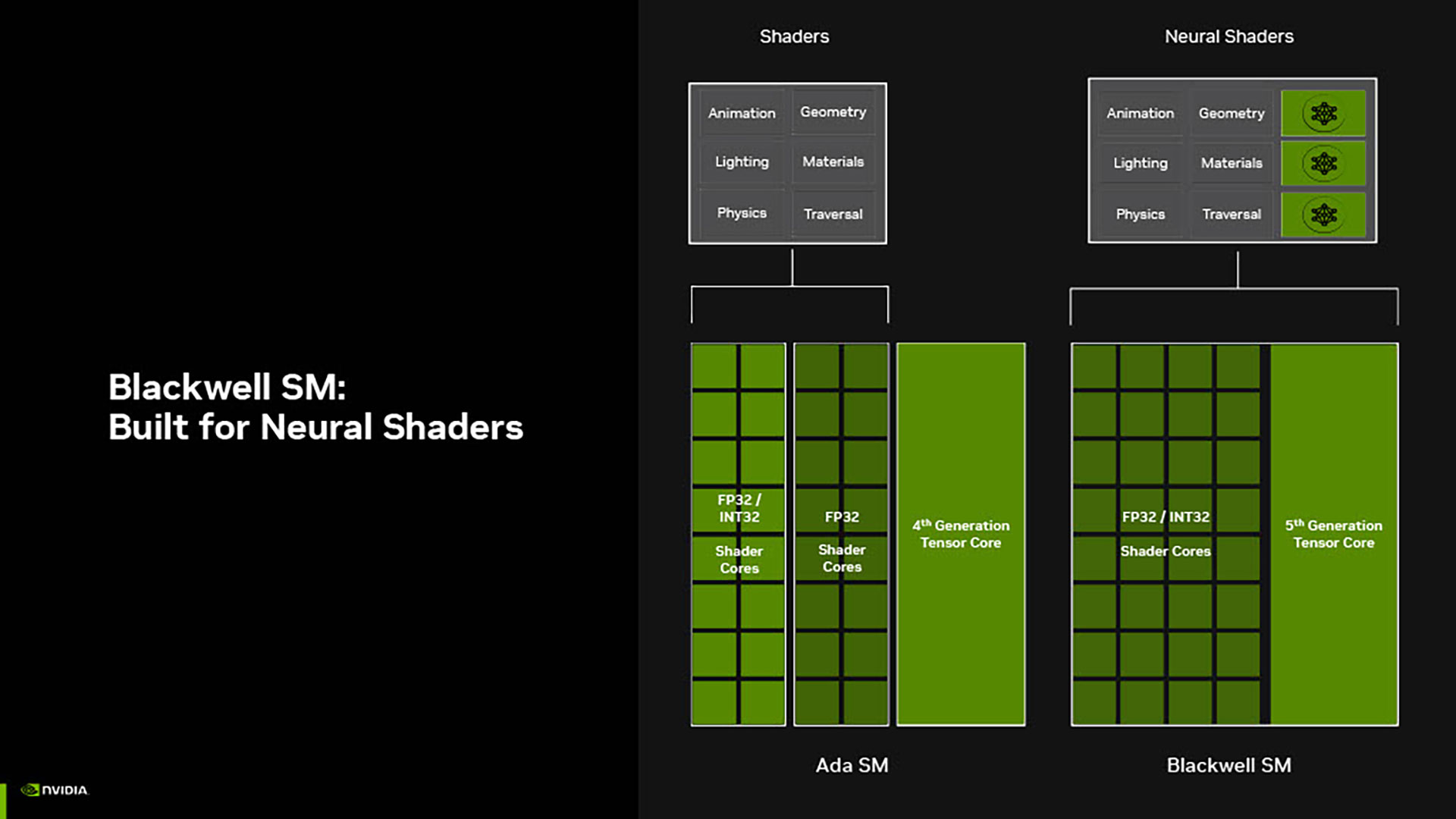

SMの構築は、ニューラルレンダリングのワークロードが増えていくことにつれて、考え方をあらためなければいかないことに気付いた。

Ada世代のSMは、スタンダードシェーダーのために設計されていた。だが、Blackwellでは「Neural Shaders」で最適化されている。整数計算のスループットを2倍にしているが、これは「Neural Shaders」にとっても重要な要素だ。

この「Neural Shaders」を2倍にするために、FP4をサポートする第5世代のTensorコアを採用しているのである。

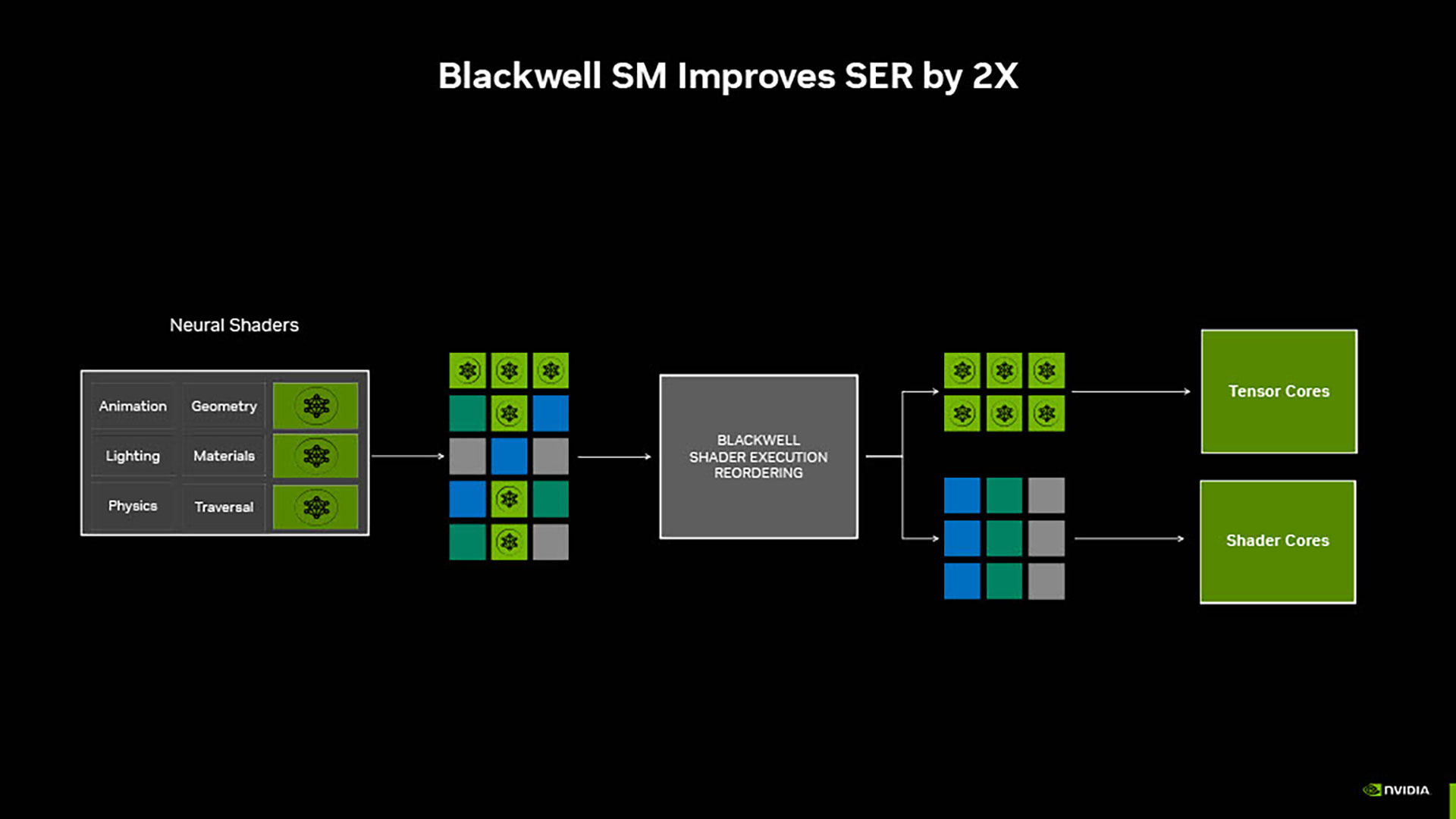

SMがコードを実行するときに、効率よくGPUが稼働するようにSER(SHADER EXECUTION REORDERING)が導入されている。

GPUが作った「Neural Shaders」の作業の中には、従来までのコードとニューラルレンダリングのコードが混ざった状態だ。だが、SER 2.0ではこれを再グルーピングすることができる。これにより、Tensorコアとシェーダーコアの作業効率を大幅に改善することができるのである。

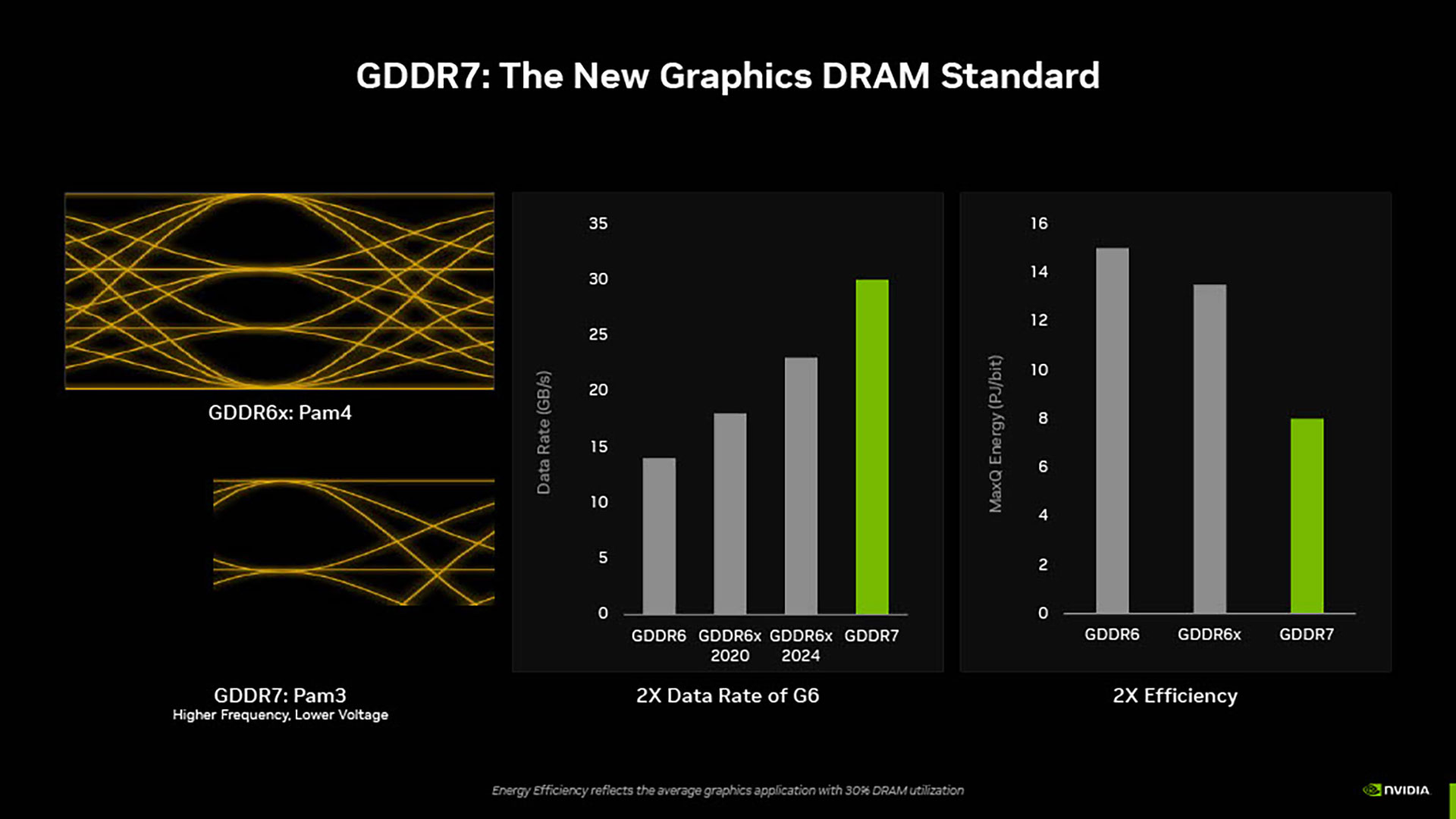

Blackwellは最初の世代として、初めてGDDR7を採用している。これによってデータレートはGDDR6と比較して2倍になり、電力消費も半分に抑えることができるようになった。

GDDR6とGDDR6xの世代では、Pam4(Pulse Amplitude Modulation 4)のテクノロジーが使われていた。こちらには4つの電圧レベルがある。だがGDDR7では、電圧レベルが3つのPam3という新しいテクノロジーが採用されている。

Pam3では、より低電圧で高い周波数を出すことができるのだ。さらには、30Gbpsという高いデータレートを実現することができ、電力効率もよくなっているのである。

ニューラルレンダリングとともに、より写実的なレンダリングを目指していこうとすると、さらに高いレベルで詳細なジオメトリーが必要になる。これを可能にするために、BlackwellではRTコアを大幅に改善している。

ニューラルレンダリングとAIを使ってゲームの体験を向上させていくためには、精度とメモリー使用量、パフォーマンスのバランスを取っていく必要があるのだ。そうした意味でFP4は多くのケースで理想的である。

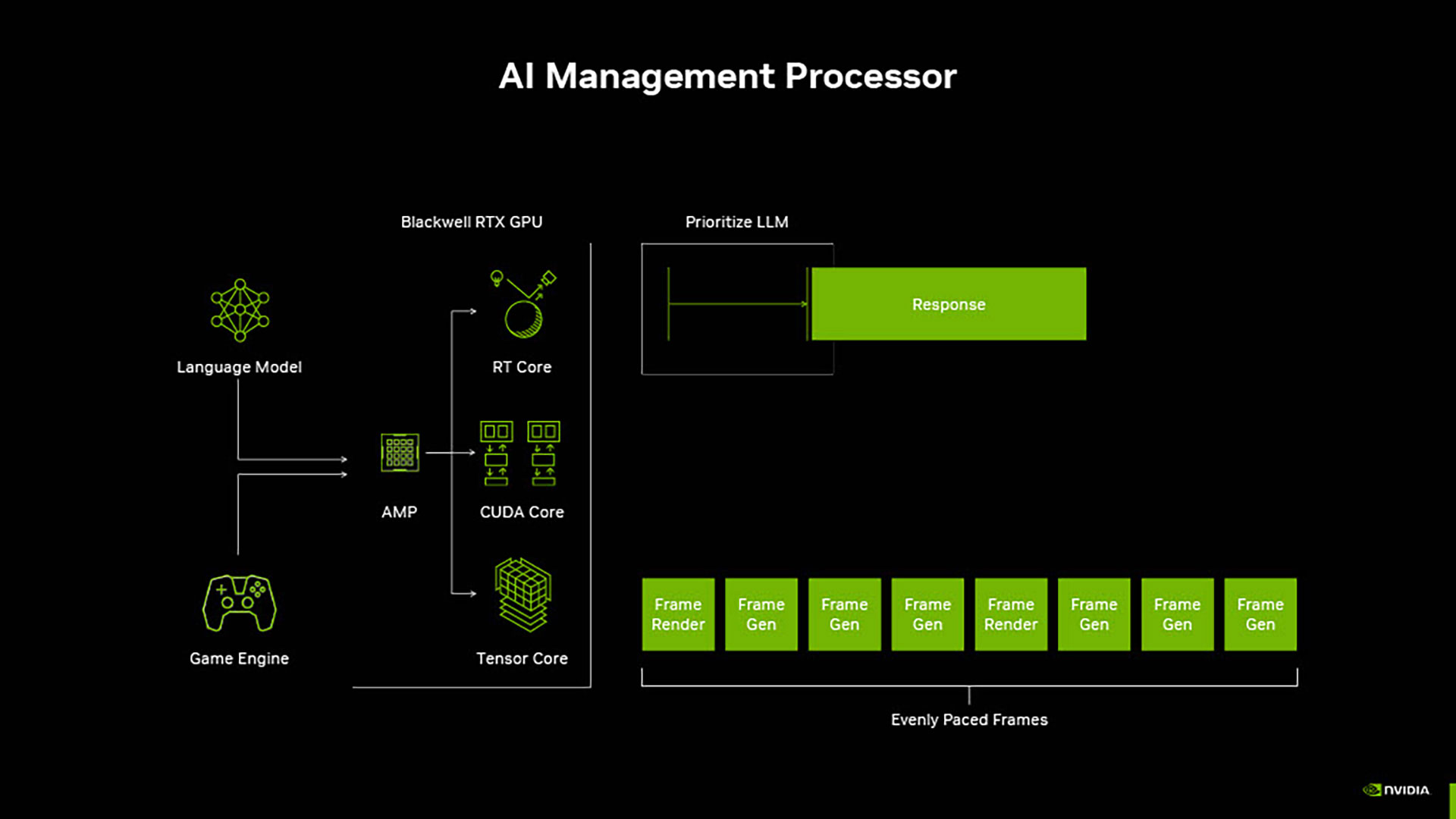

また、AIとグラフィックを平行に実行させるためには、新しいスケジューリング機能が必要であることにも気が付いた。

ゲーム内でLLM(大規模言語モデル)をする場合、最初の応答までの時間を短縮することが重要となる。チャットボットなどからの応答が遅いと、ゲームの流れが台無しになってしまうからだ。そのためDLSSでは、スムーズさと応答性が重要になる。

同社では、このスケジューリング機能に対応するために、AMP(AI Management Processor)と呼ばれるプログラム可能なハードウェアを追加している。AMPはGPUコアの近くに配置されており、フレーム生成に必要なバランスを取りながら正確な制御を行っている。

同社ではMax-Qの改善も継続的に行っている。このMax-Qの理念は、プラットフォームの電力予算から可能な限り多くのパフォーマンスを引き出すというものだ。GPUがアイドリングのときに、可能な限りより多くの電力が節約できるようにしている。

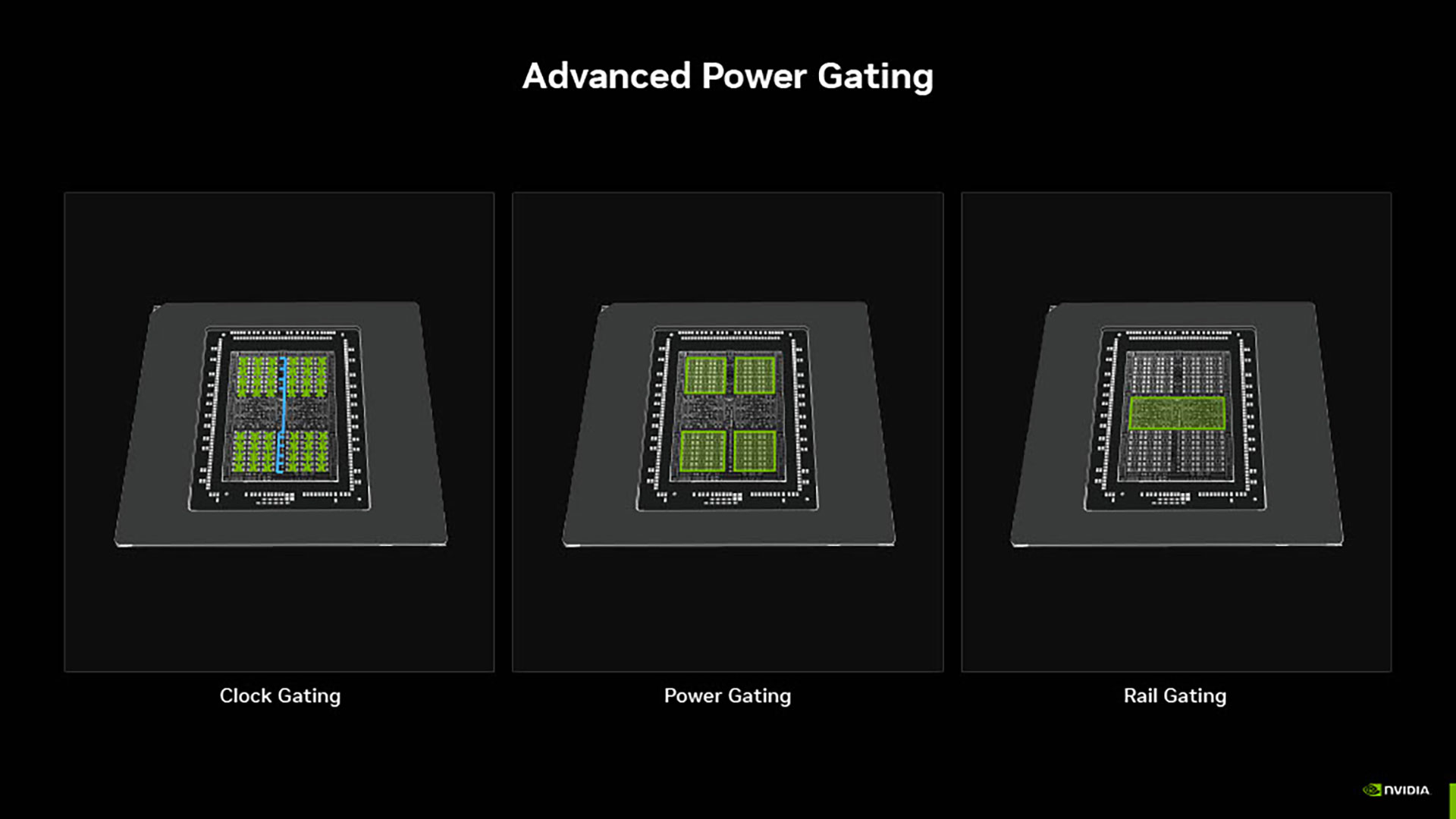

Blackwellの場合は、チップレベルで電力消費を低減する新しいPower Gatingテクノロジーが搭載されている。新しいClock Gating機能により、素早くシャットオフできるようになった。また、これまででもっともきめ細やかなPower Gating機能も採用されている。

Blackwellにより、電源状態の開始と終了の待ち時間を大幅に改善され、アクティブ電源が大幅に削減できるようになった。また、短いアイドリングであってもチップの未使用部分をシャットダウンすることが可能だ。こちらは、バッテリーを使用してゲームをプレイしているときに有効である。

AIでゲームの未来はもっとダイナミックな世界になっていく

午後から行われたセッション2では、ふたたびJeff Yen氏が登壇。先ほど説明された様々なテクノロジーを活用することで、ゲーマーやクリエイターがどのような体験ができるのかということについて紹介が行われた。

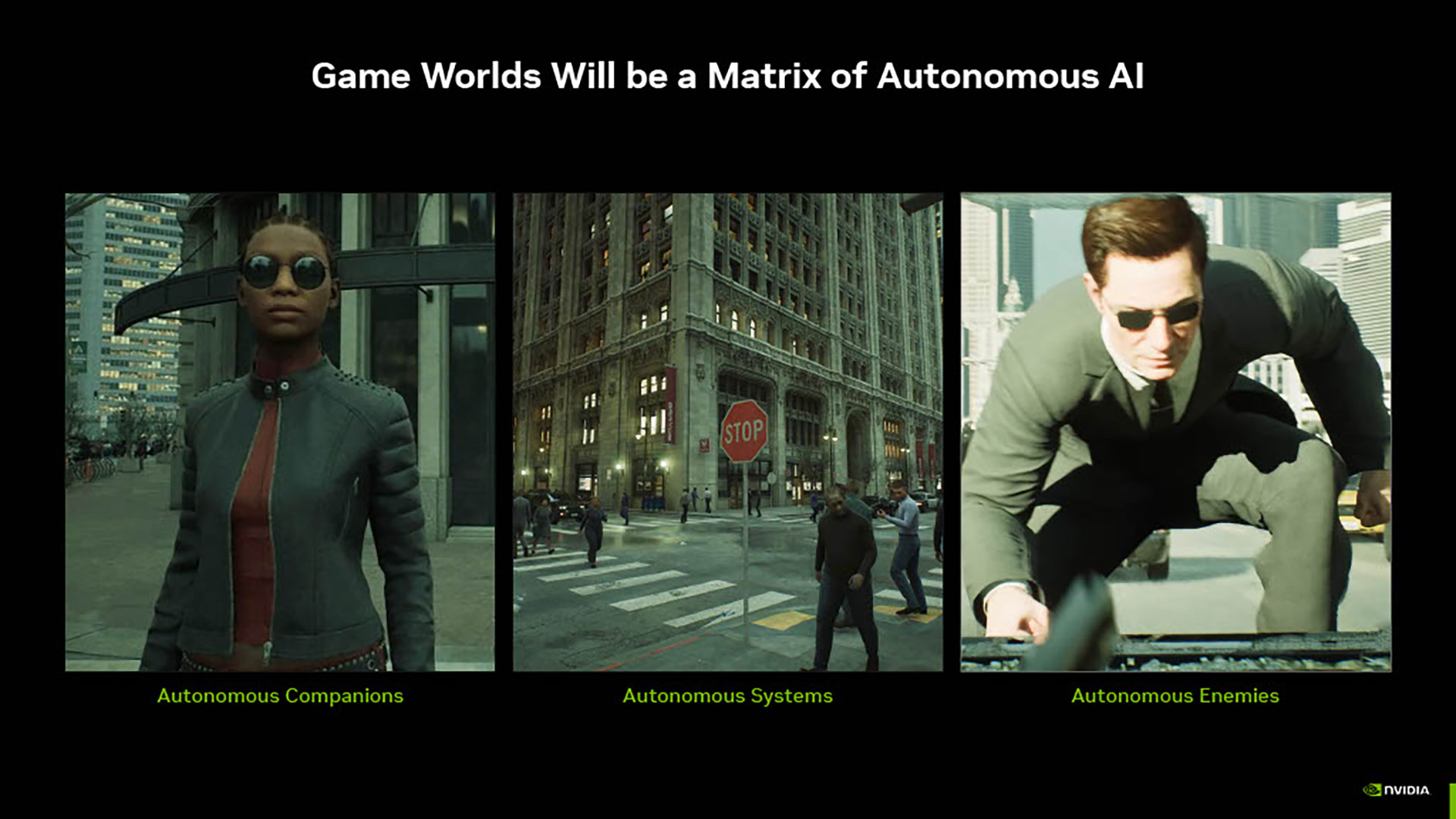

ゲームの未来は、もっとダイナミックな世界になるとJeff氏は語る。これは自立型AIによるマトリックスのような世界だ。

ゲーム開発者は、自立型のコンパニオンやチームメイト、システム、敵といったものをより多く組み込むようになってきた。これはソーシャルなダイナミックスがゲームに入ってくるということでもある。AIとプレイヤーとの間のインタラクションだけではなく、他のプレイヤーとのインタラクションも生まれる。

とはいえ、AIで人間の意志決定を複製するのは難しい。

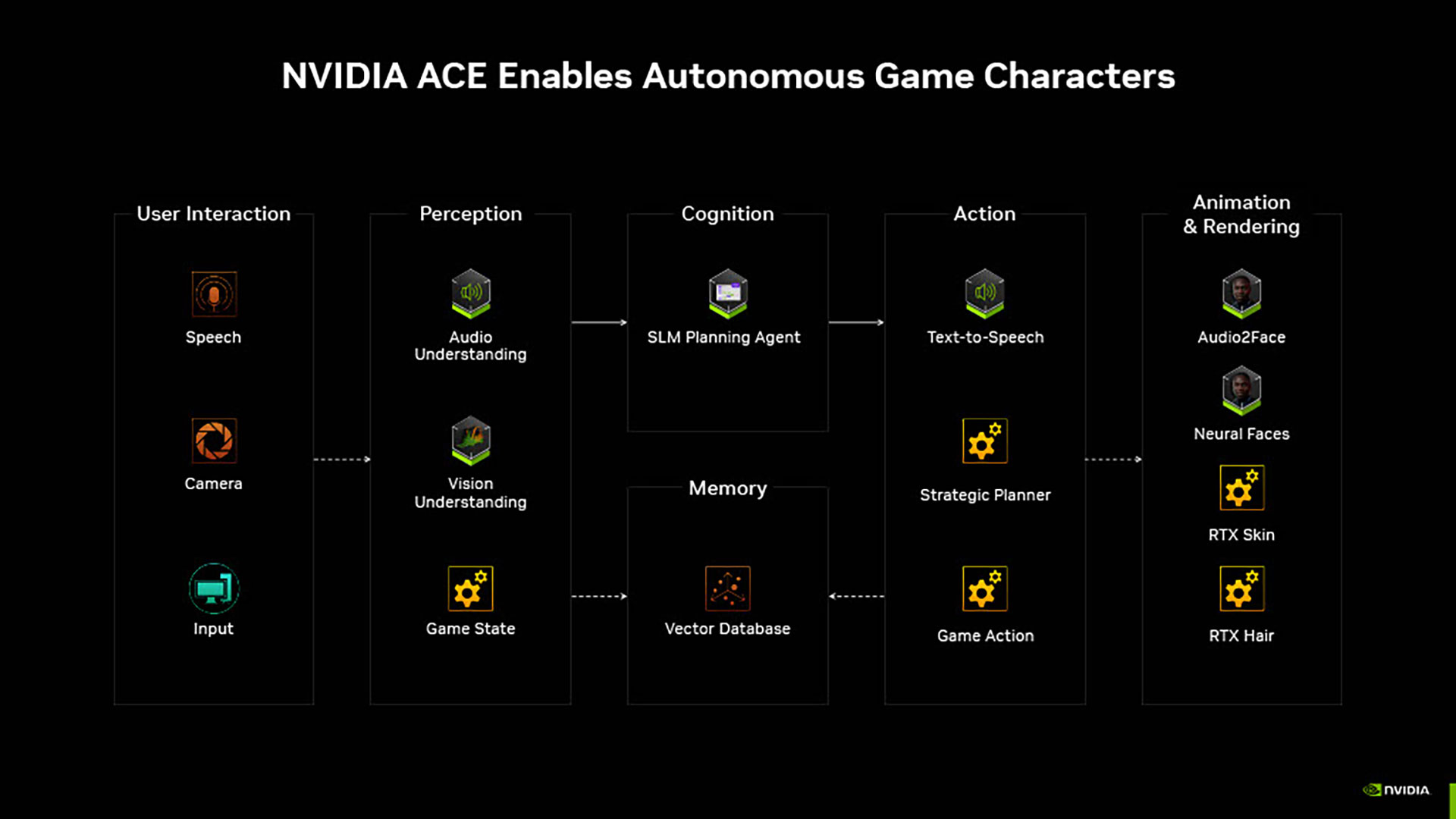

そのため、まずは世界を認識するところから始まる。その後、何をしていくのか計画を立てていく。そこで決定したことに基づき、行動を起こしていくのだ。そして、こうしたものをすべて繋ぐのが記憶である。

この記憶とは、何を見たのか、どのような決定をしたのか、最初にどんな行動をしたのかといったことすべてを、記憶するということだ。

これを可能にするために「NVIDIA ACE」を開発している。プロセスすべてをカバーするために、AIモデルを集めている。

ACEで用意されているPerception(認識)には、聴覚がある。こちらはプレイヤーからエージェントに対して話したことや、ゲームシーンの中で何が起こっているのか、遠くで発砲音が聞こえたならば、どのような状況なのかといったことを認識するためのものだ。

もうひとつ認識の要素としてあるのがVisionだ。ゲーム上に表示されるミニマップをAIが見て、敵がどこにいるのかといったことを認識し、その状況下で何をすべきなのか意志決定を行うことができる。

ゲーム状況を認識した後で、認知の部分で次に何をすべきか計画を立てていく。計画が決まったら、実際にアクションを実行していくのである。ちなみにここでいうアクションとは、必ずしも物理的に何かをするというわけではない。たとえば、AIがプレイヤーに対して返事をするということもアクションに含まれているのだ。

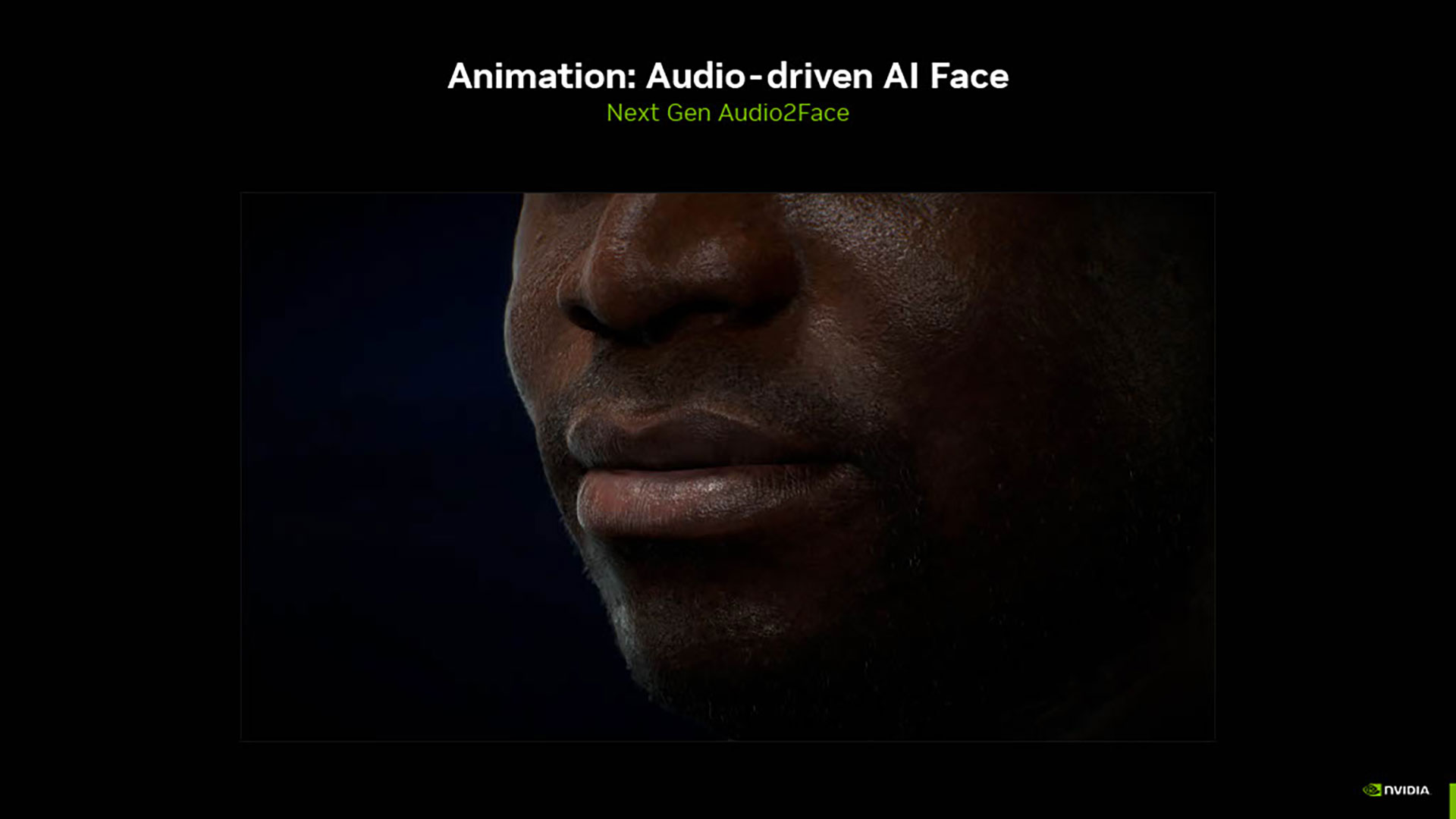

こうしたAIは、可能ならばリアルに見えた方がいい。それを実現しているのが、次世代の「Audio2Face」である。こちらは単純にリップシンクするだけではなく、表情も変化させることができる。また、「あっ!あっ!」といったような、非言語のコミュニケーションを行うことも可能だ。

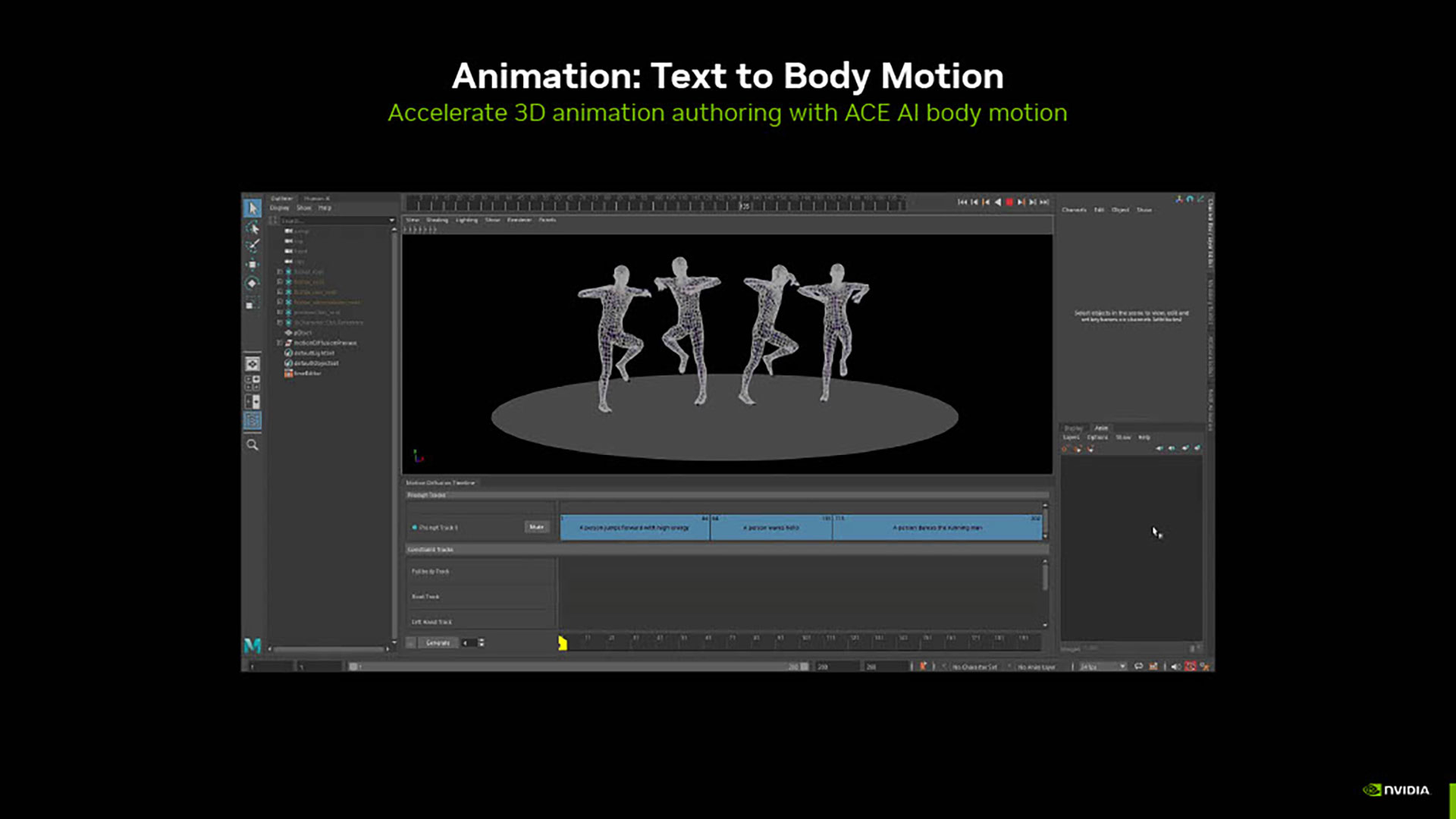

よりリアルに見せるためには、顔だけではなく体の動きも重要だ。そこで使われているのが「ACE AI Body Motion」である。

こちらは、キャラクターがどのように歩いてほしいのかテキストで記述していくことで実現できる機能だ。これはひとつの歩き方だけではなく、様々な動きが表現することが可能となっている。

たとえば障害物の周りを動き回ったり、あるいは4人のキャラクターが個性的に動いているように見えるようにしたりといったこともできるのだ。

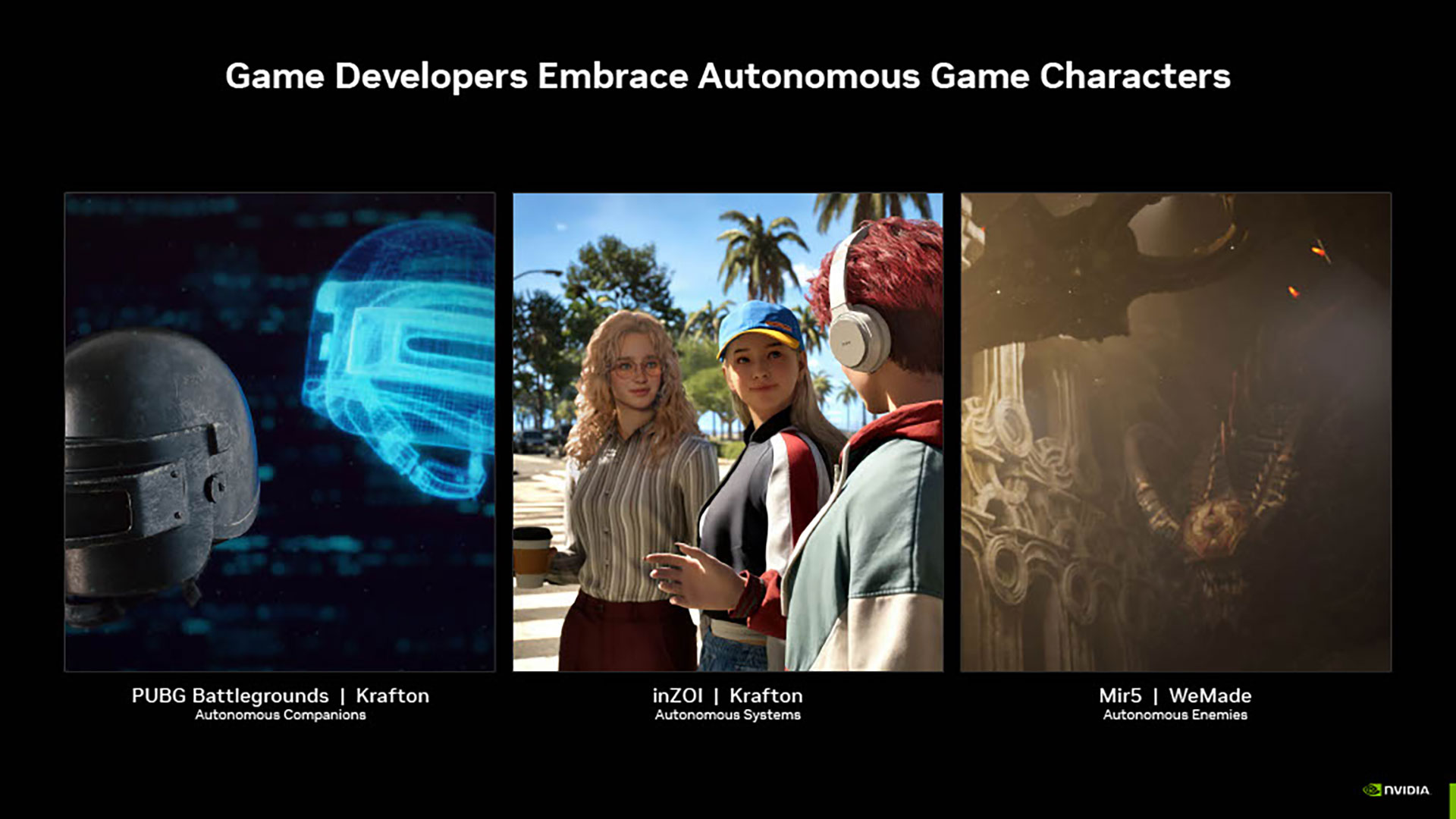

ACEはゲームの中で自律的なキャラクターを作るために使うことができる。たとえば『PUBG Ally』では、一緒にプレイするチームメイトをAIで作ることができるようになった。

『inZOI』にも、「Smart Zoi」と呼ばれる自立型のシステムが組み込まれている。また『Mir5』では自立した敵を表現するためにACEが使われている。そして、これこそが将来のゲームの姿であると、同社では考えているのだ。

ゲーム以外の用途でも活用されるようになってきたAI

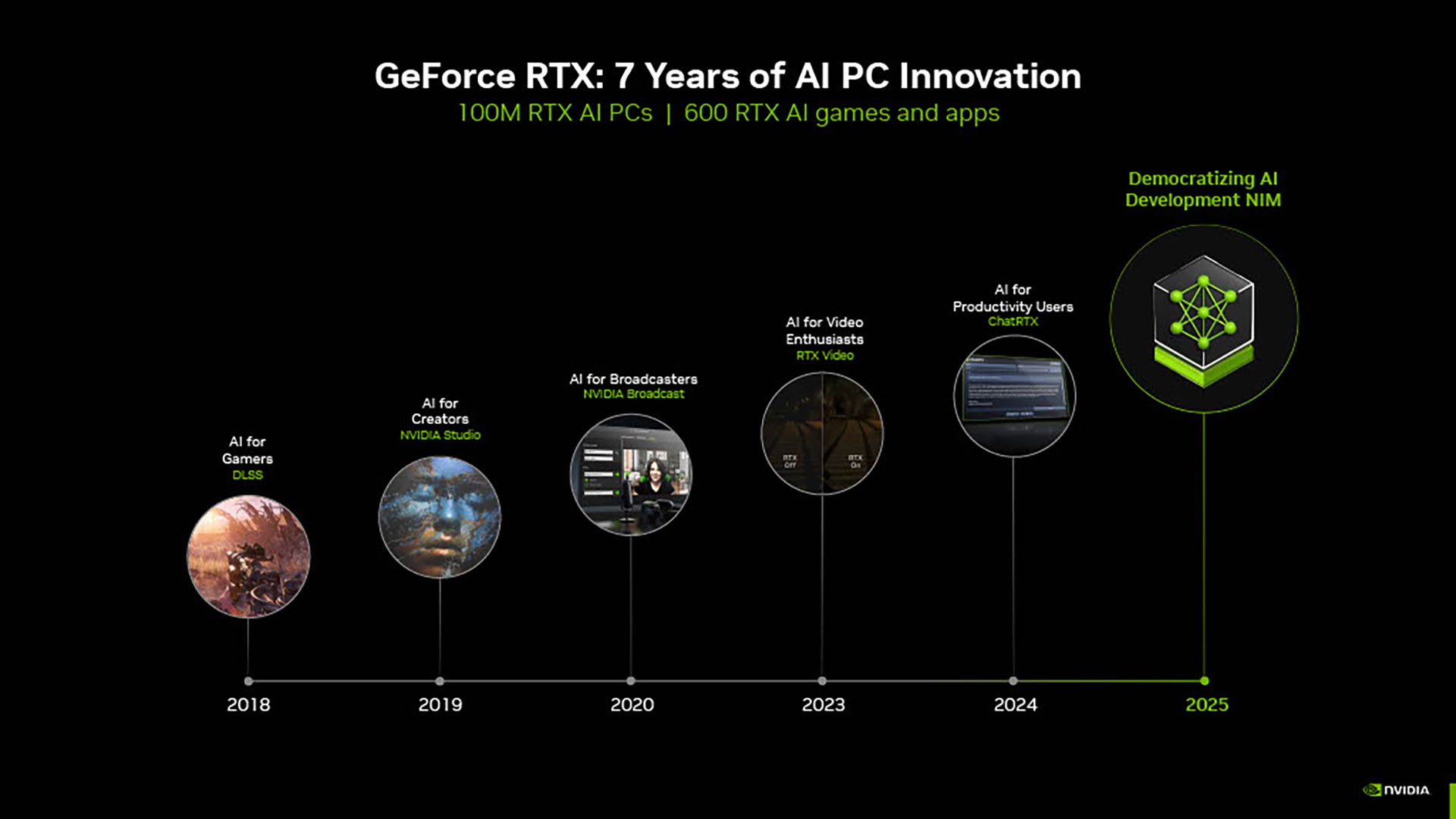

このAIは、ゲームだけに活用されているわけではない。PCの体験を改善するAIを導入するために、同社ではこの7年間対応してきた。最初に登場したのは、2018年のDLSSだ。

その後クリエイターやブロードキャスターなどで活用できるものを増やしてきた。このAI開発はPCにも活用されるようになってきたのだ。

これまでは大学でコンピューターサイエンスを学び、開発者になっていた。だが、今は生成AIの時代に突入しており、ゼロコードまたはほぼノンコードでアプリケーションが作れるようになってきた。これにより、デベロッパーの見方も大きく変わってくる。

現在ソフトウェアの開発者は、全世界で3000万人いると言われている。だが、生成AIによって少しでも興味を持つ人たちが開発になることもできるようになったのだ。

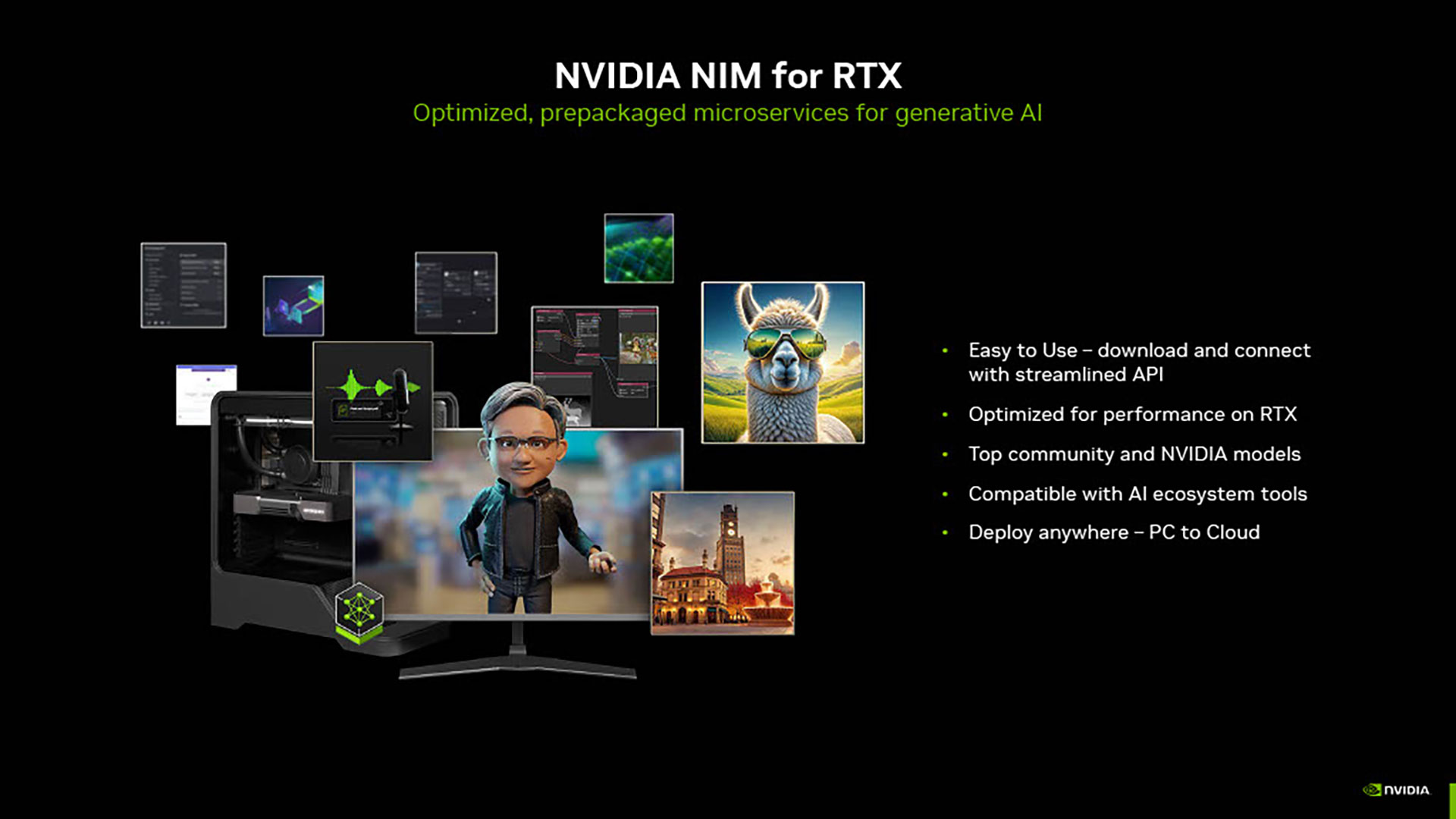

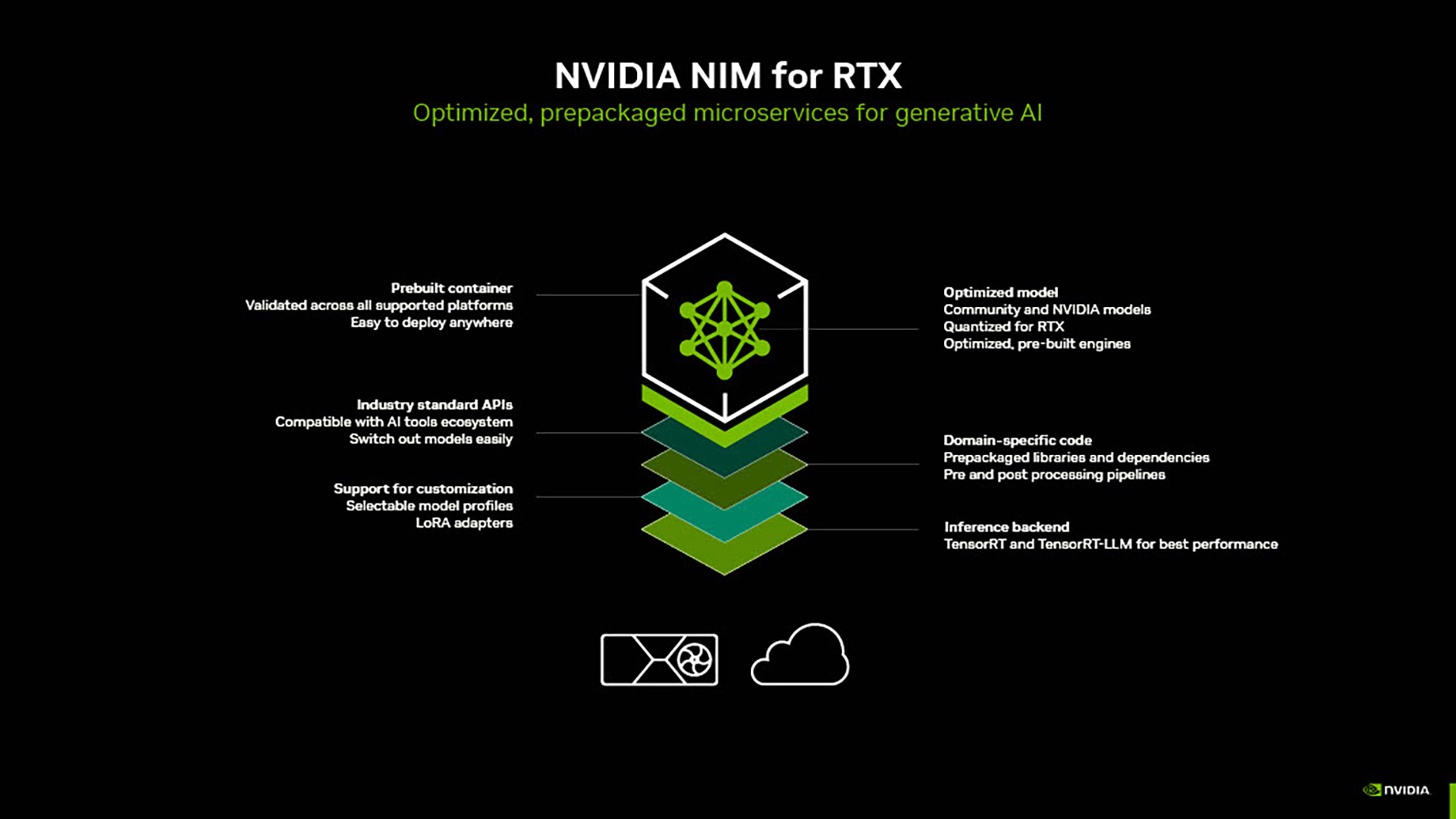

つまり、開発者の数も2億人以上になるということでもある。そこで導入されたのが「NIM」(NVIDIA Inference Microservices)だ。

この「NIM」には、最適化されたモデルやドメイン固有のコードにする機能、パフォーマンスの改善、カスタマイゼーションのサポートなどが含まれている。これらはすべてコンテナ化されており、使い勝手もいいのが特徴だ。

こちらはライセンスでリリースされるほか、今後も様々な機能が追加されていく予定だ。

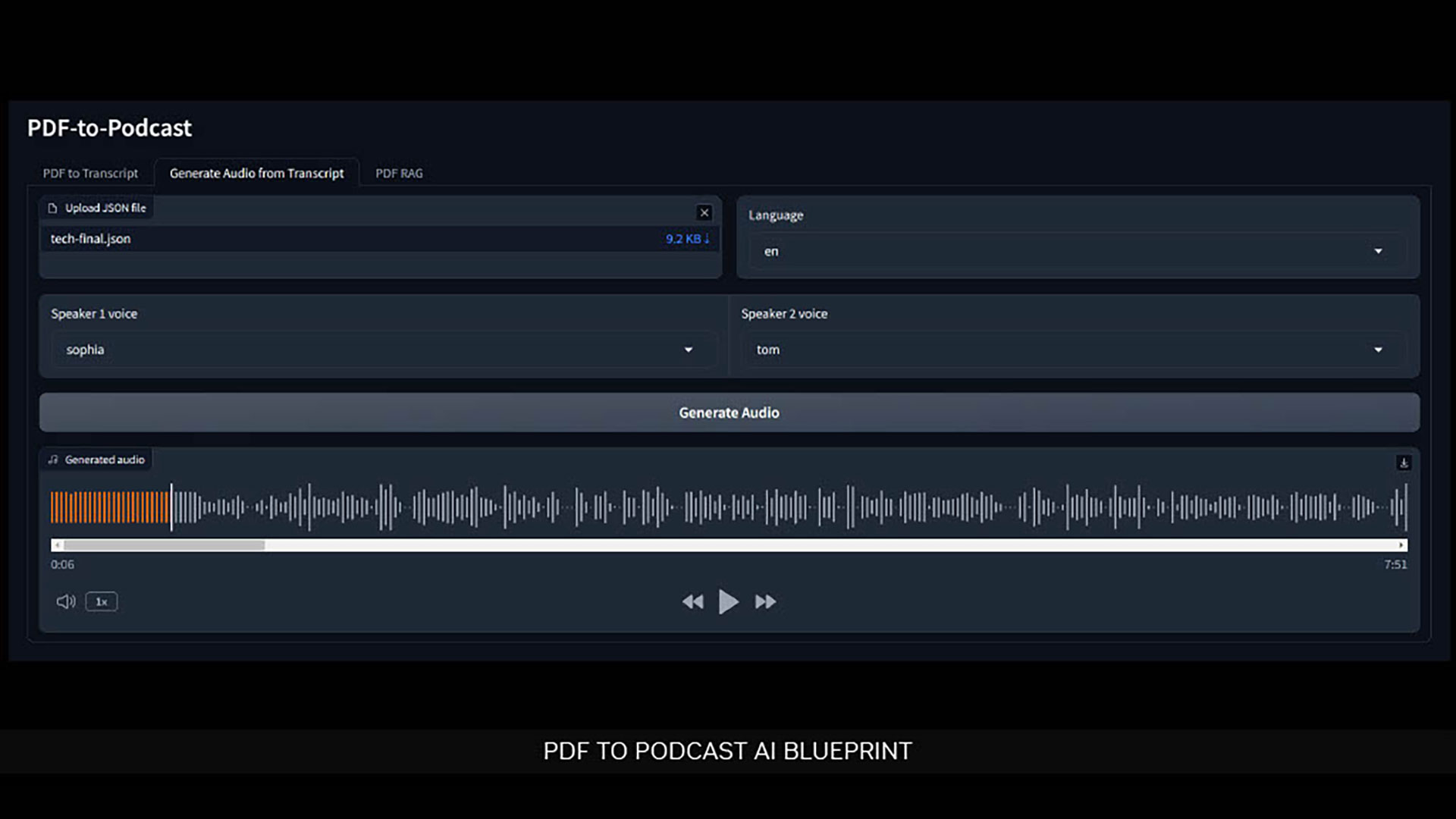

同社からは、RTX用の「AI Blueprints」も発表されている。その中のひとつが「PDF to Podcast」だ。

こちらは、PDFをPodcastに変換して音声で文章を聞くことができるようにするというものだ。たとえば技術的なテキストを読むのはなかなか大変だ。そこでPodcastに変換することで、より気軽に文章の内容を把握することができるというわけである。

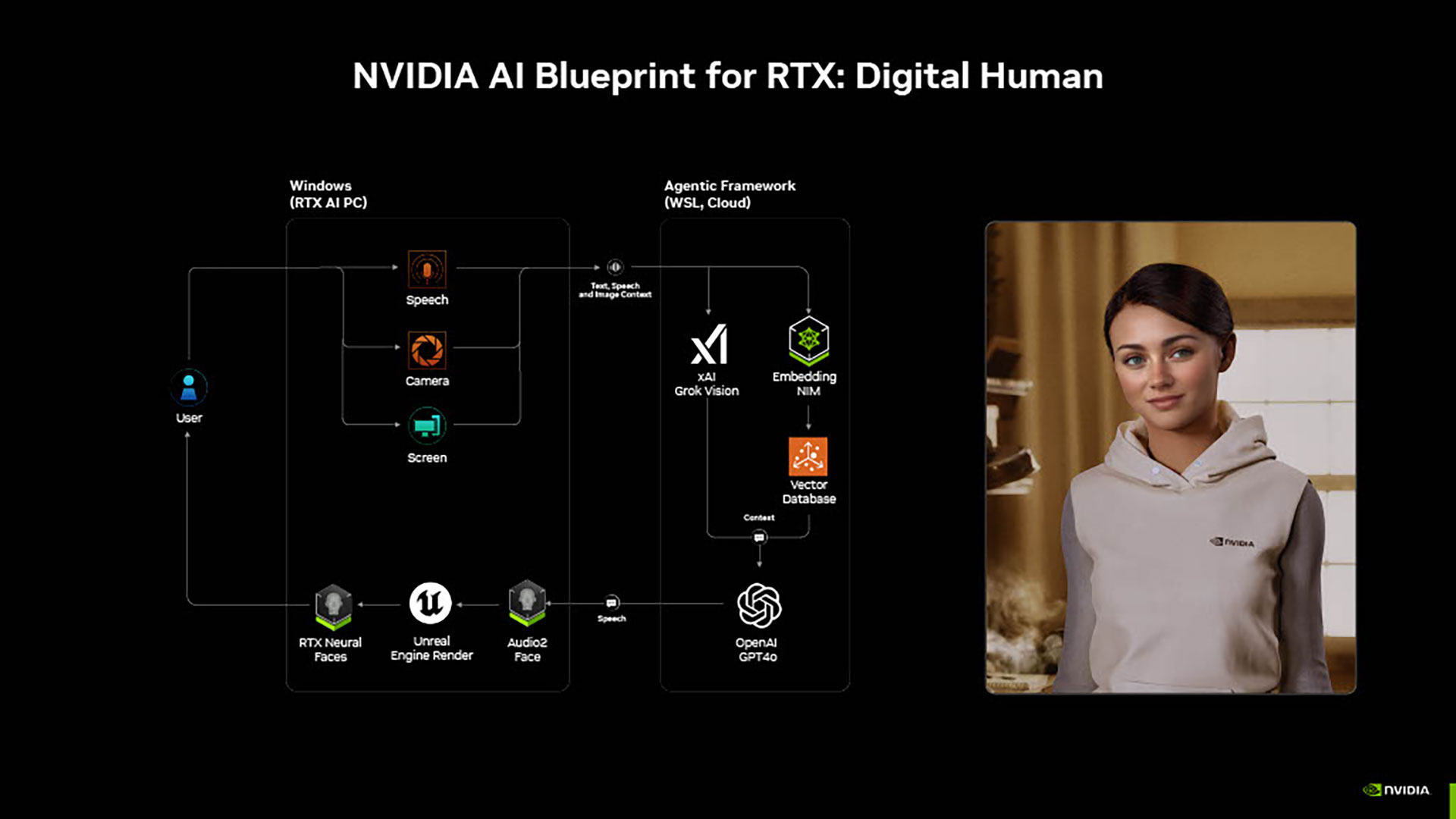

また、この「AI Blueprints」には「デジタルヒューマン」という機能も含まれており、リアルなエージェントとして会話を楽しむことができるようになっている。

Blackwell を活用することでクリエイターの生産性も大幅に向上

Blackwellは、クリエイター向けにも活用することができる。

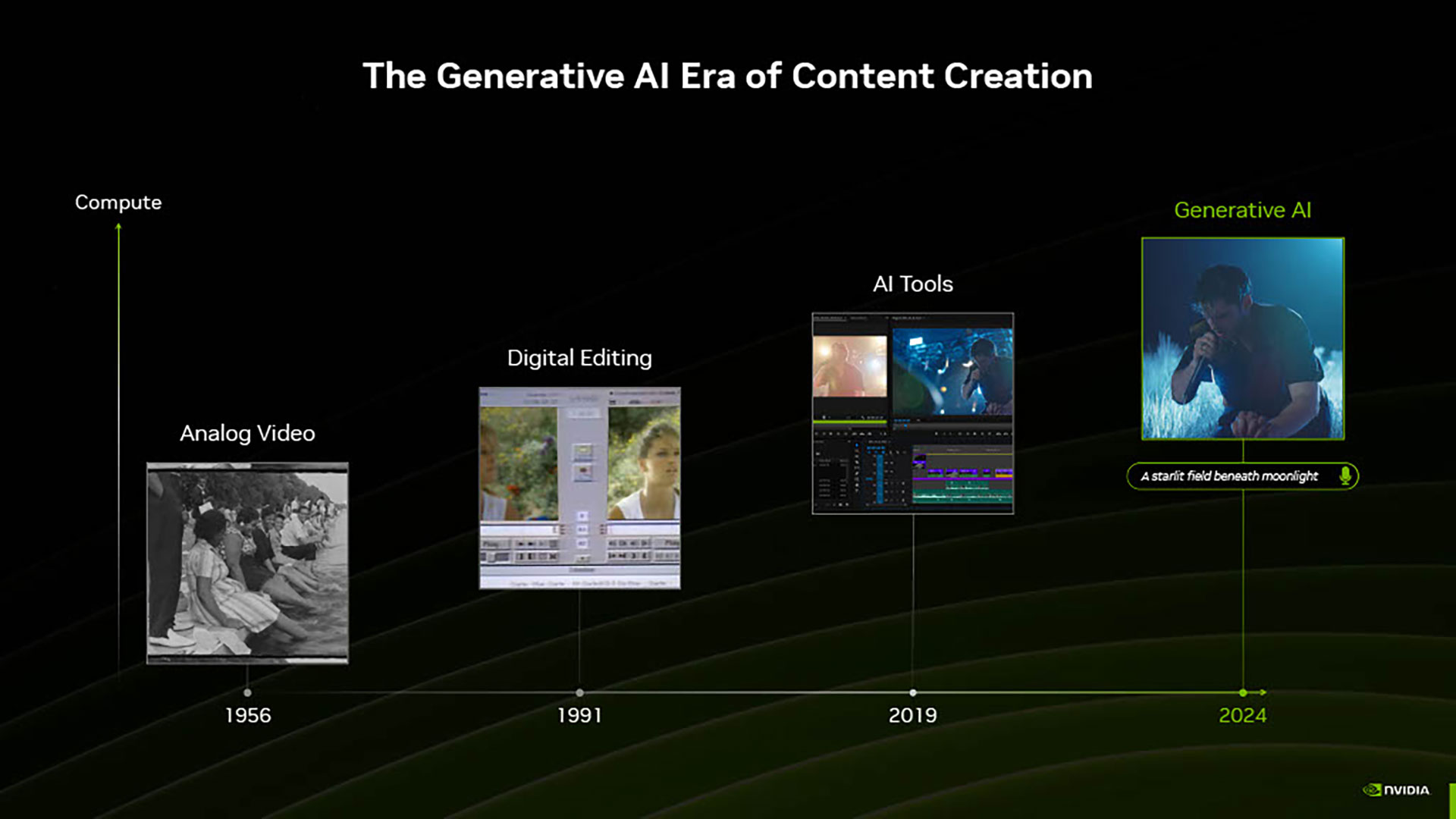

コンテンツの作成は、時代によって大きく変化してきた。最初はフィルムによる撮影が行われていたが、デジタルを使った編集に変わった。そしてAIツールが登場し、さらには生成AIが導入されるようになったという感じだ。

しかし、GPUのコンピューティングやVRAMの使用量と比較すると、AIの開発のほうが先行している状態である。生成AIは以前からあったものの、使われるようになったのはつい最近のことだ。それも、まだまだ最終形には到達していない。

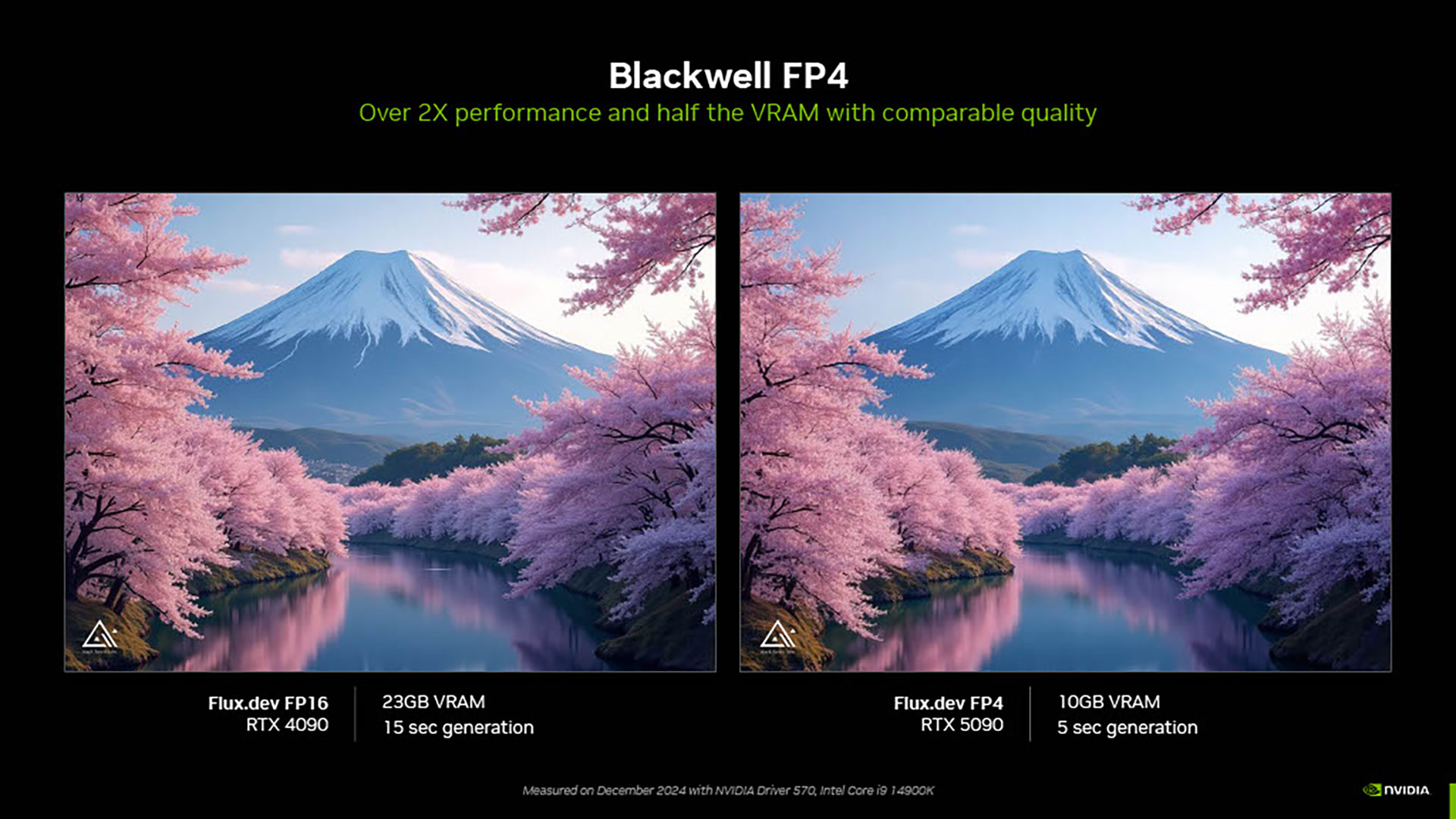

こうした状況に対してBlackwellで生み出したソリューションがFP4だ。同等の画像品質の表示でも、FP16では23GBのVRAMが必要だが、FP4では10GBまで抑えることができる。また生成時間もFP4のほうが大きく短縮することができるのだ。

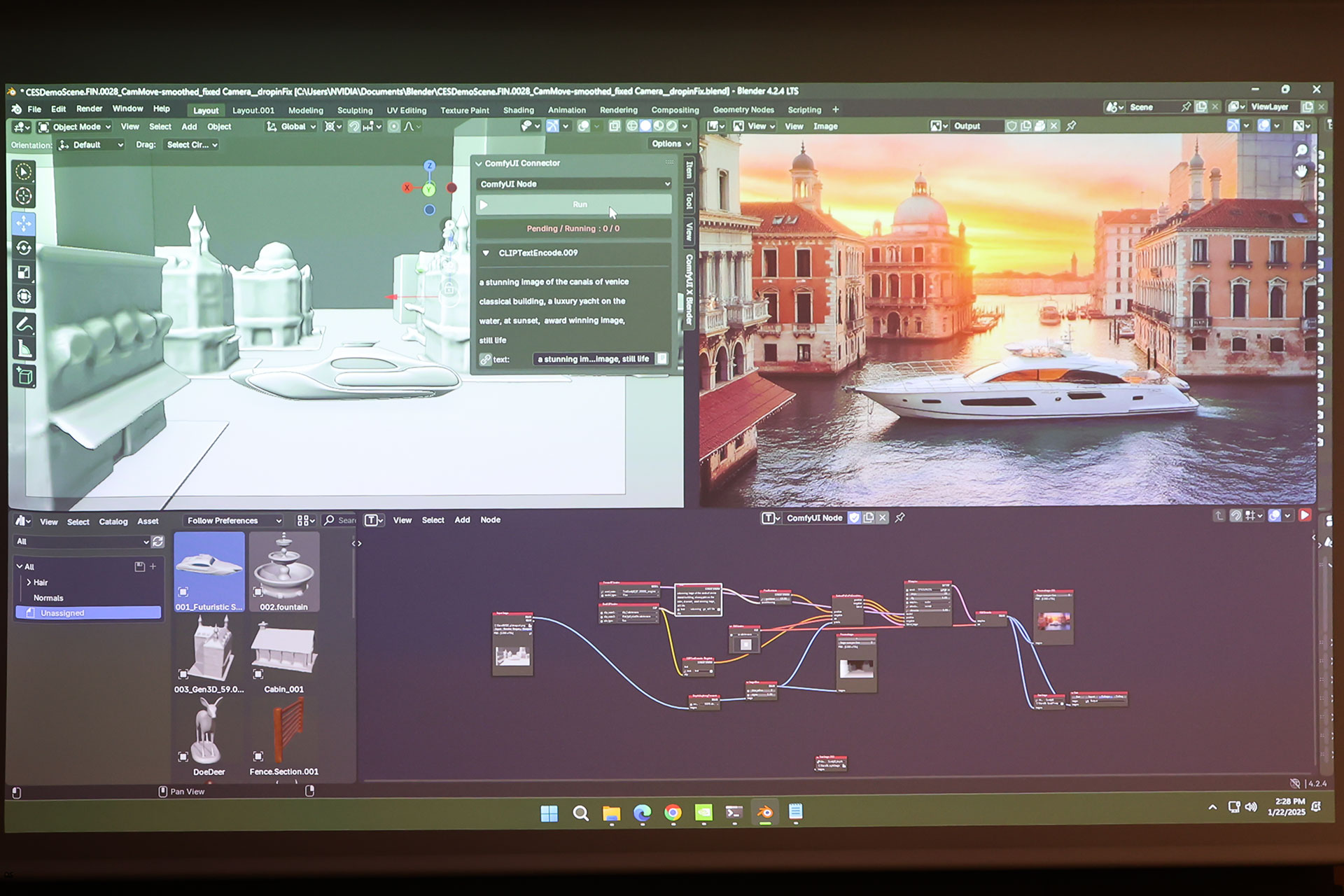

「3D Guided Generative AI Blueprint」を使うことで、3Dソフトの『Blender』上での操作も行えるようになる。

たとえばデータセットとテキストを組み合わせることで、石畳をベニスの皮に変更できたり、水に船を浮かばせたりといったことも指定するだけで簡単に生成することができる。

テキストと3Dの情報を組み合わせて画像が生成されるため、3Dのオブジェクトを少し動かすだけでも反映されるようになるのだ。

Blackwellでサポートされている、もうひとつのクリエイター向けソリューションが4:2:2のビデオフォーマットだ。

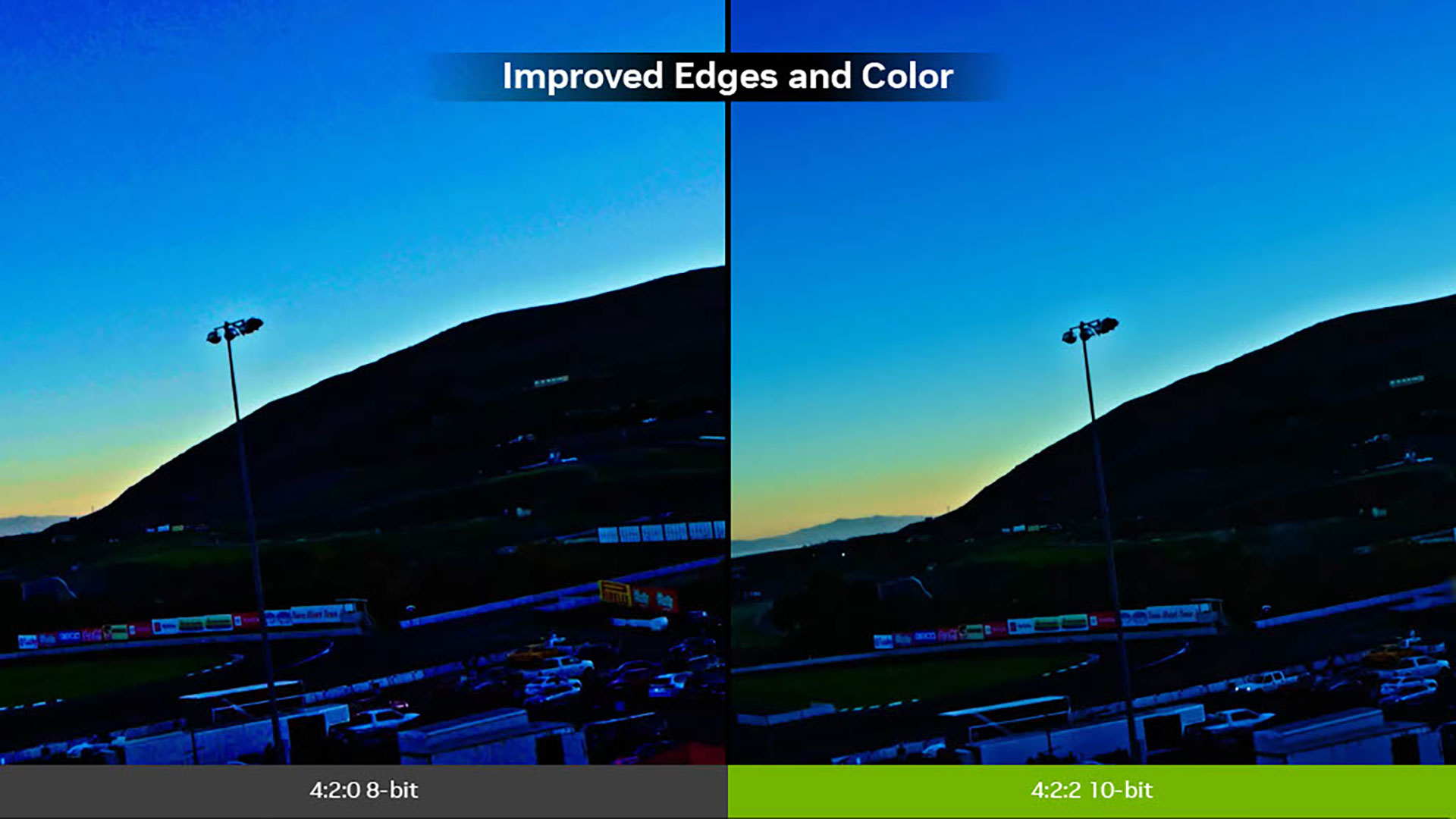

以前はカメラが高価なものだったが、その値段が下がり多くのユーザーが4:2:2のフォーマットを使用するようになってきた。少しだけファイルサイズは増えるものの、これによりカラーも2倍になった。

現在ネット上で使用されているフォーマットのほとんどは4:2:0だ。しかし、高いクオリティの動画が要求されるようになってきたということもあり、バランス良く4:2:2のフォーマットが使える時代にもなってきた。

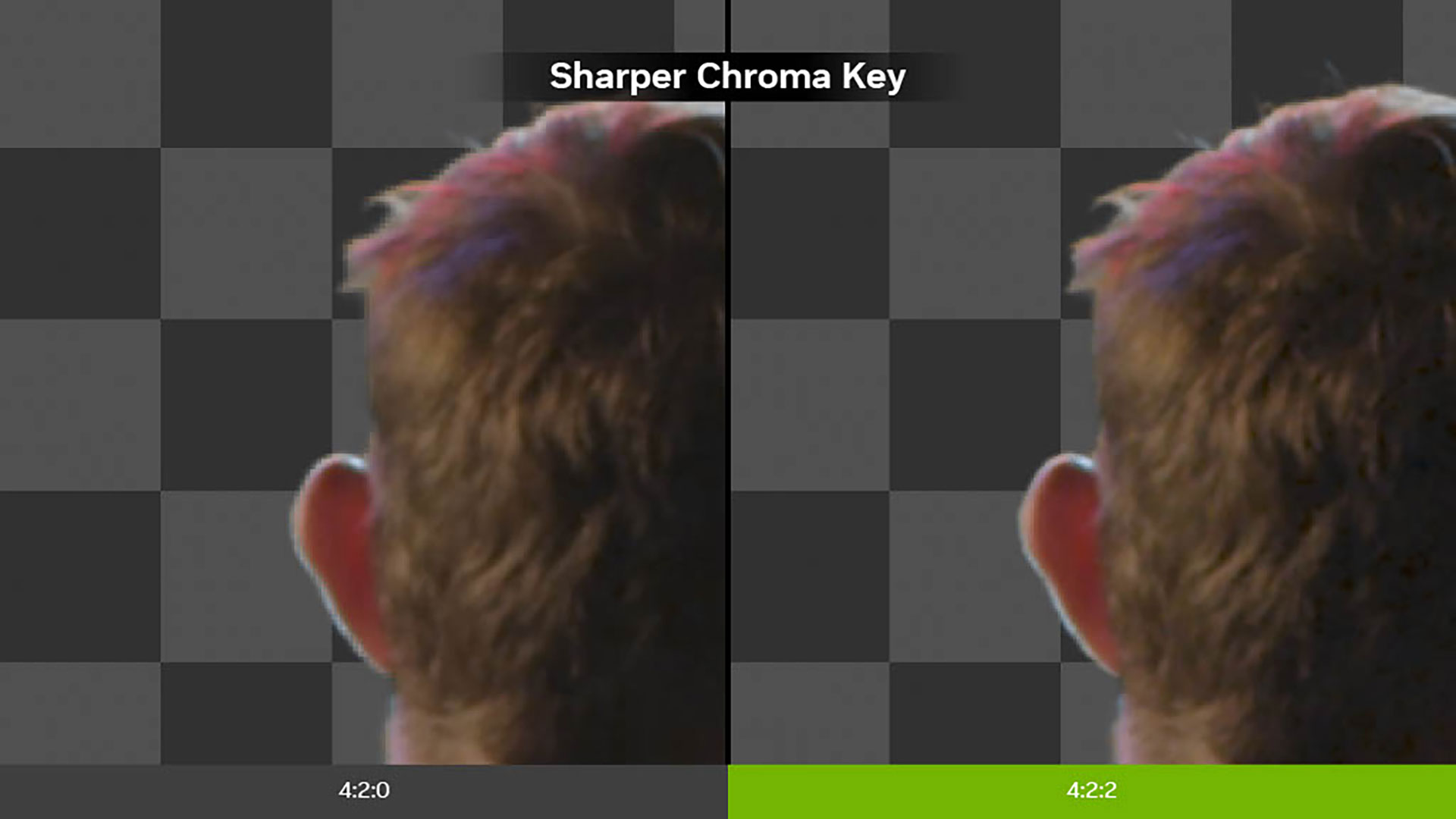

4:2:2では色が正確に出せるだけではなく、バウンディングも少なく細部をアップしても映像も綺麗だ。また、クロマキーでも輪郭が綺麗に映し出せる。

この4:2:2のデコードとエンコードが、Blackwellには含まれている。以前は4:2:2のエンコードはCPUに送る必要があったのだが、RTX 5090を使用すると、11倍速く処理することが可能になったのだ。

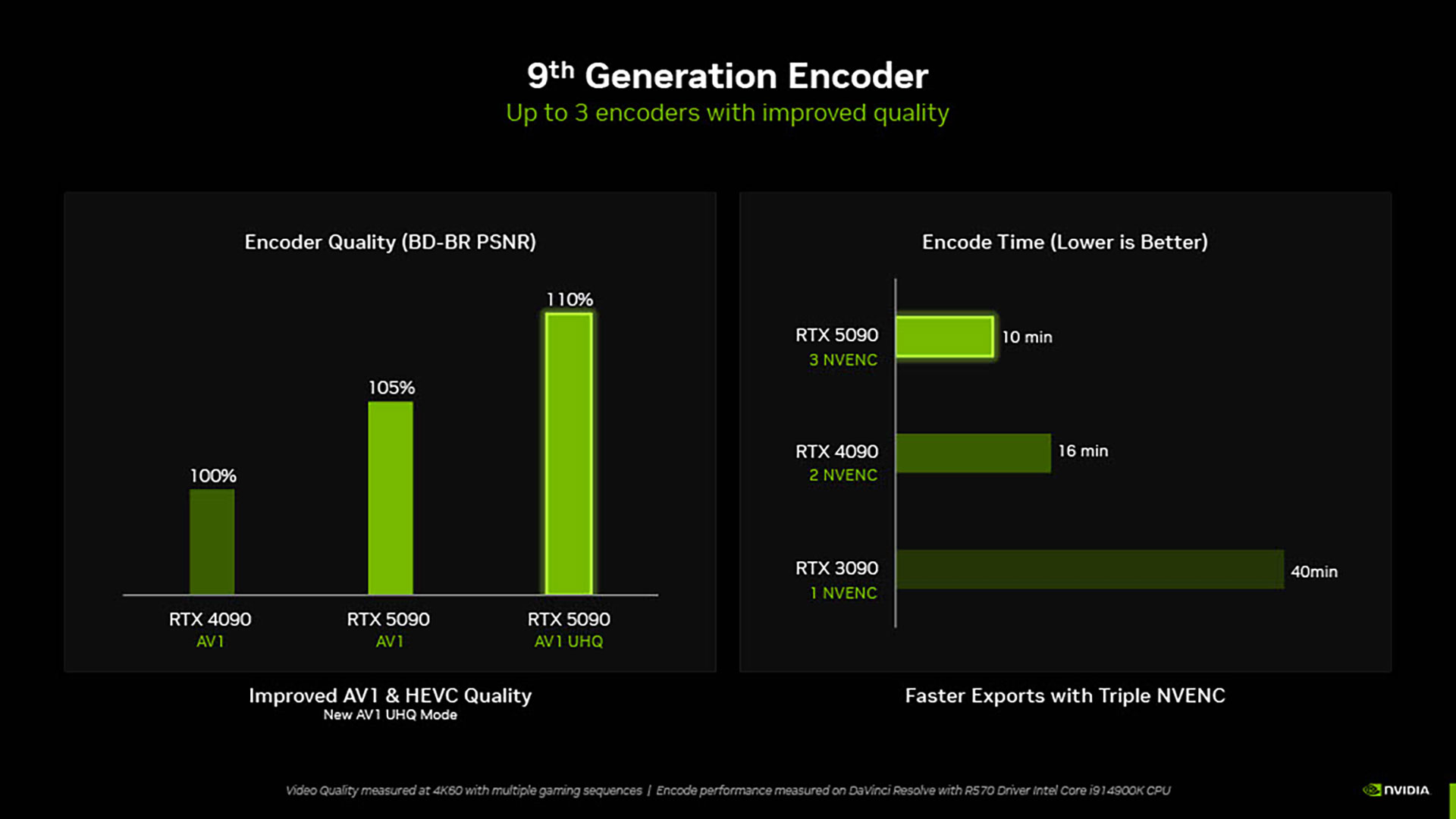

また、Blackwellでは第9世代のエンコーダーが採用されている。3つのエンコーダーまで入れることができ、速度が上がるだけではなく品質も向上している。さらには、第6世代のデコーダーも入っているのだ。

このようにRTX 50シリーズではプロが使用する動画編集ソフトでも恩恵が得られるのである。

同社ではライブストリーマー向けにも、素晴らしいソリューションを提供している。こちらで注目したいのが、新しい「スタジオボイス」と「バーチャルキーライト」のふたつだ。

「スタジオボイス」は、屋外で収録したボイスのノイズをAIが除去し、スタジオで収録したような音質まで引き上げることができるというものである。

「バーチャルキーライト」は、配信者の顔に最適な照明が当たっているように見せる技術だ。こちらでは、「AI face relighting」と呼ばれる機能を使い、入力された人の映像をAIで補正してくれる。

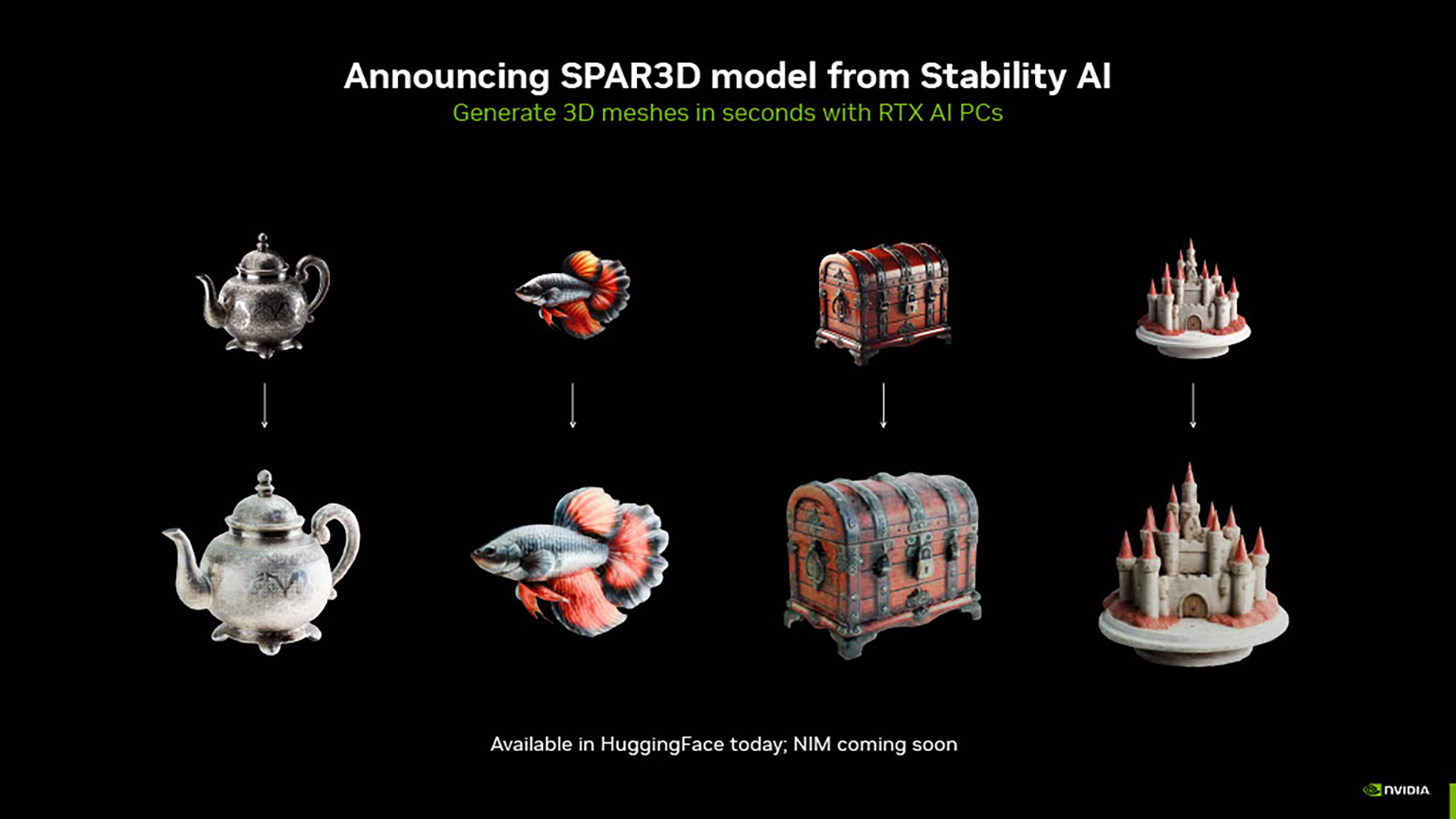

様々な機能をご紹介してきたが、3Dのレンダリング機能もクリエイターが利用できる。また、近々2Dから3Dモデルに変換できる機能も搭載される予定だ。

Jeff氏は、このGeForce RTX 50シリーズのまとめとして、「素晴らしいテクノロジーはゲーミングだけではなく、クリエイターサイドでも使っていただくことができます。アーキテクチャやシェーディングの素晴らしいテクノロジー。AIの3Dレンダリングまで幅広い分野でメリットを享受してもらえます」と語り、今回のイベントを締めくくった。

かなり駆け足ではあったが、想像以上に膨大なテクノロジーが詰め込まれている製品であることは間違いない。

グラフィックボードというと、どうしてもゲーマー目線で選んでしまいそうだが、より幅広い場面で活躍することが多くなってきそうだ。