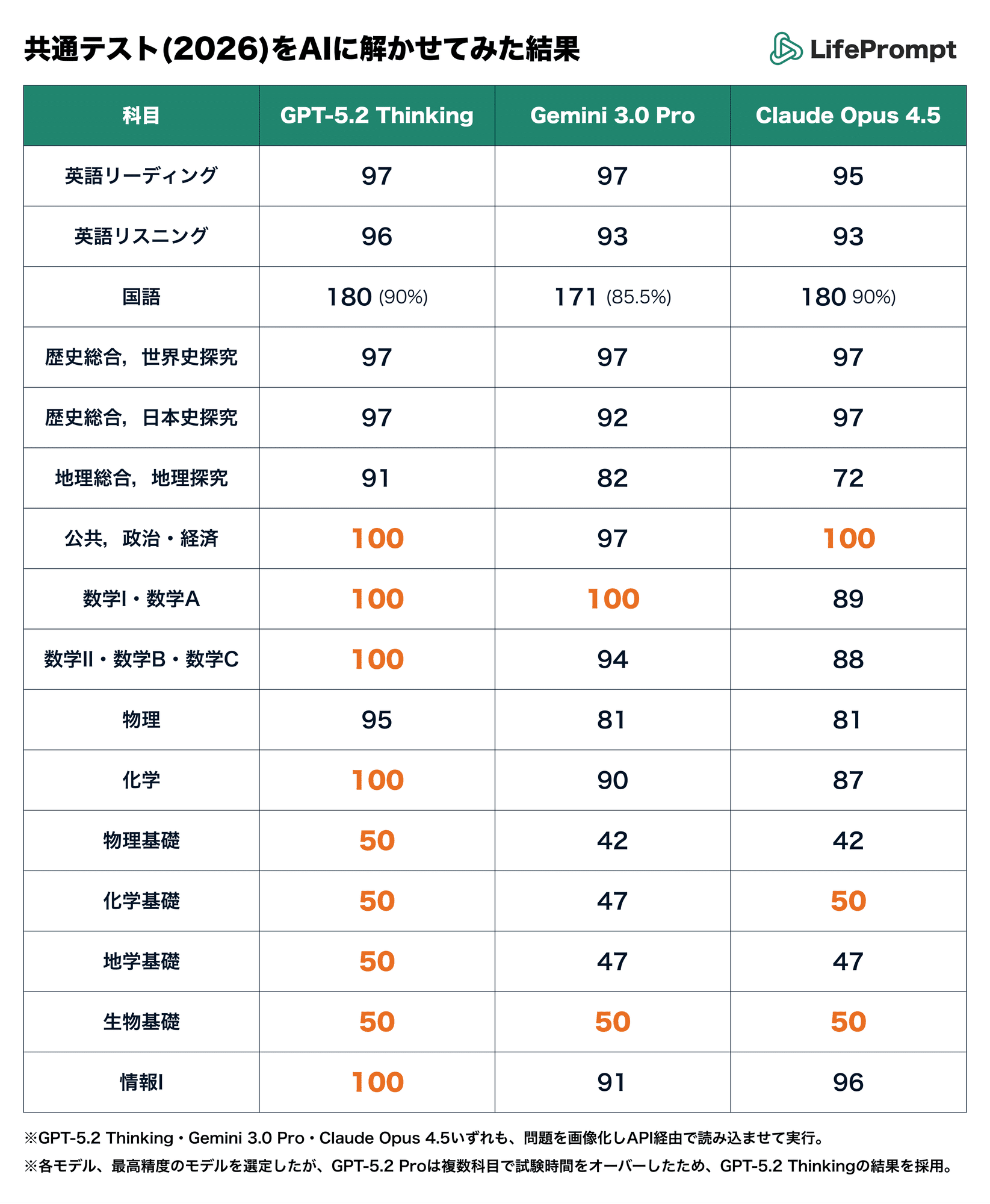

1月20日、AIベンチャーの株式会社LifePromptは、2026年の大学入学共通テストを最新の生成AIに解答させた検証結果を同社noteの記事にて公表した。

今年で4回目となる本実験には「ChatGPT」「Gemini」「Claude」という3つのLLMが投入され、その中でもChatGPTの最新モデル「GPT-5.2 Thinking」が、9科目において満点を獲得している。

今回の検証は、専用システムを通じて問題PDFを画像化し、API経由で各AIに入力するという環境下で実施された。各モデルの実力を引き出す調整も行われ、ChatGPTには数分間の思考時間を許容し、ClaudeやGeminiには思考プロセスや画像認識精度を高める設定が適用されている。

なお、音声データの入力が困難な英語リスニングについては試験センター公開の読み上げスクリプトを、AIが読み取りを苦手とする縦書きの国語については事前に文字起こししたテキストデータを代替入力する措置がとられている。

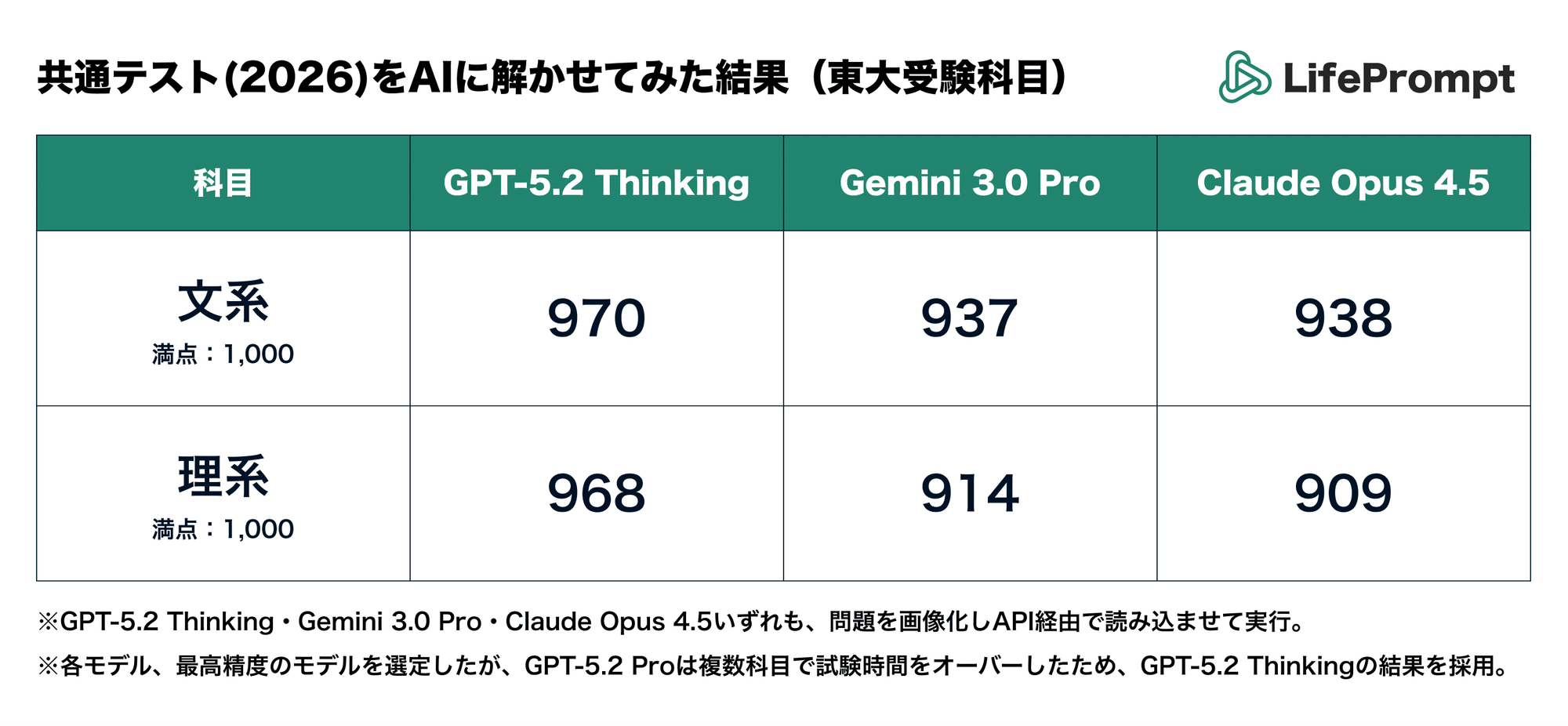

結果としてChatGPTは「数学1A」「数学2BC」「公共、政治・経済」「化学」「物理基礎」「化学基礎」「地学基礎」「生物基礎」「情報1」の合計9科目で満点を記録。実際の受験生の選択科目に合わせた総合結果においても、文系970点、理系968点(いずれも1000点満点)を獲得した。GeminiとClaudeは900点前半で競り合う結果となっている。

【満点9科目!】共通テスト2026を最新版AIに解かせてみた(Chatgpt、Gemini、Claude)

— 遠藤聡志 / LifePrompt inc. (@endo_lifeprompt) January 20, 2026

今年も共通テストをAIに解かせてみました!

昨年までは考えられなかった「満点」もいくつかあり、毎年の定点観測として今年もまた興味深い結果になりました pic.twitter.com/5J5WnDW3d0

昨年からの顕著な進化として、図形問題への対応力が低く苦戦した数学IAにおいて、今年のChatGPTは図形を「絵」ではなく「座標データ」として脳内で再構築して処理することで満点を獲得した。

また、日本史においても、単なる単語の暗記にとどまらず歴史の因果関係や文脈を深く理解できるようになったことで、資料読解問題を含めて正解を導き出せるようになったという。

個別の設問における、各AIの挙動の違いも明らかにされている。地理総合の問3、南米の雨温図と地図を照らし合わせる問題で、他のAIが位置情報とグラフの結合に失敗する中、Geminiのみがアンデス山脈が位置する地図上の地形と気候グラフの特徴を、視覚的に正しくリンクさせることに成功した。

一方で、英語リスニングのバス乗降口のイラスト選択や、国語の小説における複雑な心情理解では全モデルが誤答しており、視覚情報の論理的解釈や人間特有の感情の機微については、依然としてAI共通の課題であることが浮き彫りとなった。

なお同社は、今回の共通テスト検証に続き、東京大学の二次試験にAIを挑戦させる企画も既に始動させている。昨年の検証では「理三合格ライン突破」という結果を残しているが、2026年も同様に合格判定を得られるか注目が集まりそうだ。