ボイスチャット関連技術を開発するスタートアップ企業Modulateが、AIと機械学習を利用してオンラインマルチプレイゲームのボイスチャットから有毒な発言を削除・通報するシステム「ToxMod」のサービスを開始した。

Modulateは、ToxModを世界初の音声向けモデレートサービスと呼んでおり、サービスを導入した企業はリアルタイムで有毒な発言を監視、検出できるという。ToxModは現在英語のみに対応しているが、今後韓国語、ドイツ語、スペイン語など、多数の言語に対応予定だ。

ToxModは、いわゆるFワードや人種差別的な言葉を検出したり、見つけた場合自動的にそのユーザーをミュートするだけではない。その言葉が出た文脈まで検討し、攻撃的なのかそうでないかも検出可能だという。そのため、「Fuck」や「Shit」といったわかりやすく攻撃的な文章だけでなく、文脈から発言の攻撃性を検出して学習していく。

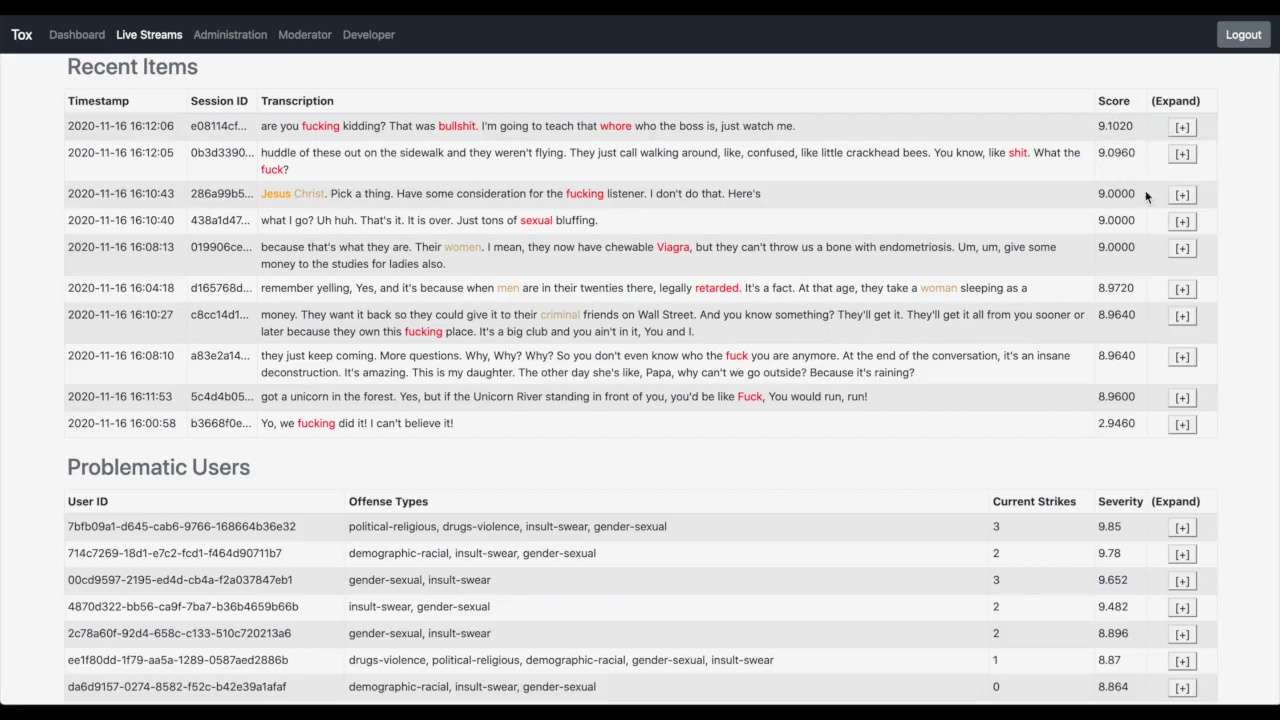

上記のデモンストレーションではユーザーが発言した言葉をテキスト化し、攻撃的だと思われる言葉をハイライトしている。Fuckに関連した言葉が多いが、ほかにも危険度によって色分けされた「Jesus Christ」や「Bullshit」なども見られる。

その文章が攻撃的かどうかはスコアとして計算されていることも分かる。「are you fucking kidding?」から始まる発言はとくにスコアが高く、攻撃的な言葉だと判定されている。

一方で「Yo, we fucking did it!」という文章はスコアが低い。一応検出されているが、ほとんどの場合この文章は仲間と一緒になにか喜んでいるときに出てくる言葉だ。攻撃性は薄いとして判定されているようだ。

こうした発言から自動的に発言者のボイスチャットをミュートにしたり、個人情報を含む特定の単語やフレーズ単位でのミュート、あるいは意図的か否かにかかわらず音量が大きすぎる参加者の音声を適切なレベルに変更したりもできる。自動的に対処するだけでなく、一旦問題のユーザーに警告を出したり、人間のモデレーターに引き継ぐことも可能だ。

ToxModがどのようなゲームに導入される予定かは公表されていない。しかし、毒性の強いユーザーのボイスチャットが、ほかの多くのユーザーにとって害悪であることは間違いない。ボイスチャットの対抗法は、現状ユーザーの通報がもっとも一般的な方法だろう。

この技術が公約通りに動き多くのゲームが導入すれば、そういった攻撃的な言葉は大きく減ることが期待できる。

ライター/古嶋 誉幸